Mediakwest : Julien, peux-tu te présenter à nos lecteurs ?

Julien Demeulenaere : J’ai 34 ans et je suis expert de la tape (bande magnétique) chez IBM, responsable du chiffre d’affaires (de l’ordre de 100 millions d’euros) et brand manager pour l’Europe depuis 2018. À la base technicien avant-vente, j’ai travaillé avec plusieurs grands de l’informatique avant de rejoindre IBM. Chez Dell j’ai beaucoup appris sur le stockage et les serveurs, j’étais expert virtualisation certifié pour VMware et j’ai travaillé chez Veeam qui a envahi le marché de la protection de données.

Je me suis interrogé il y a cinq/six ans sur le prochain big bang informatique. La réponse est facile c’est le quantique, qui arrivera au minimum dans dix à quinze ans. C’est alors que j’ai pris conscience des énormes qualités de la bande magnétique et de sa grande capacité d’amélioration alors que la mort du disque dur magnétique est annoncée sous une échéance de dix à quinze ans. Les besoins en volumétrie de stockage sont en perpétuelle augmentation, l’unique solution pour conserver des données à un prix contenu est « la tape ». La technologie des disques durs SSD coûte dix à vingt fois plus cher.

Depuis cinquante ans on annonce la fin de la bande magnétique, pourtant son chiffre d’affaires augmente depuis quatre ans chez IBM. Depuis les cassettes VHS, la tape a disparu chez les particuliers. Elle disparaît également dans les petites entreprises, remplacée pour les petites sauvegardes par les disques durs, les clés USB ou encore le cloud.

Par contre les entreprises de grande taille qui centralisent les données, les spécialistes du stockage en ligne vont tous y passer. La majorité d’entre eux ayant déjà amorcé la transition avec des fermes de dizaines de milliers de lecteurs et de millions de cartouches. Les nouveaux grands acteurs sont d’accord avec l’analyse technologique du marché faite par IBM : la bande magnétique est la seule technologie envisageable pour de larges quantités de données.

M. : Peux-tu nous préciser ta fonction chez IBM ?

J. D. : J’ai un rôle hyper hybride : je fais du business management et du commercial et je fais le lien avec la R&D en tant que spécialiste technique. Nous sommes un petit écosystème comparativement à des projets générant des millions d’euros. Localisé en France, mon rôle est européen avec une vision mondiale pour IBM. Il y a vingt ans, le public de la bande magnétique était beaucoup plus large. Aujourd’hui uniquement les gros acteurs sont concernés ; des compétences beaucoup plus profondes sont nécessaires. Le labo de recherche est à Zurich, le labo de développement à Tucson en Arizona. Mes homologues américains, japonais et chinois s’appuient sur les équipes commerciales d’IBM hardware.

M. : Peux-tu nous présenter les différents types de stockage du marché ?

J. D. : Il y en a trois : le disque SSD à mémoire flash, le disque dur magnétique et la bande magnétique. Le flash est le plus performant avec une latence très basse et un très grand nombre d’IO (échanges entrées-sorties) possibles surtout avec le nouveau protocole NVMe qui remplace le SCSI existant depuis vingt à trente ans. Le grand public se soucie principalement du débit des disques, qui est important lorsqu’on télécharge de gros fichiers. Mais lorsque de très nombreux clients commandent simultanément un même article, une base de données mondiale est interrogée. Les débits en jeu sont ridicules : quelques octets environ. Par contre l’opération engendre des millions de requêtes.

Une recherche faite sur Google est partagée par des milliards d’êtres humains, cela nécessite une architecture IT et une solution de stockage capable de supporter des millions d’IO. Si vous disposez d’un débit important avec des possibilités d’entrées-sorties limitées, vous créez un énorme « goulot d’étranglement ». Le protocole ouvert NVMe, sorti il y a quelques années maintenant et qui se démocratise depuis 2018 permet de multiples opérations en parallèle (64 000). C’est une vraie révolution désormais disponible pour les particuliers ; certaines cartes mères supportent des disques ressemblant à des barrettes de mémoires flash avec des coûts de 2 à 300 euros.

Pour répondre à une requête, la tête d’un disque dur magnétique doit l’explorer pour récupérer tous les blocs un par un. Il n’y a que la multiplication des plateaux qui permet de multiples opérations sur ces disques (jusqu’à neuf plateaux). La technologie NVMe est donc arrivée pour répondre aux possibilités des disques « flash ». Pour tous les besoins de performance le flash s’impose. Pour les bases de données, le débit des disques durs magnétiques suffit, c’est la rapidité de réponse à une quantité de requête qui compte ; c’est la force des disques « flash » NVMe.

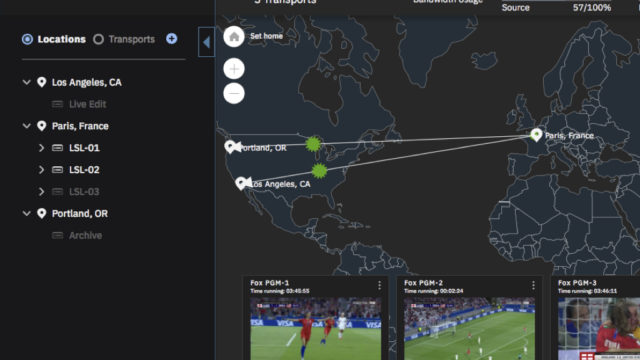

M. : Peux-tu nous illustrer ces propos dans le domaine qui nous intéresse, celui des médias ?

J. D. : Si on étudie la mise en place d’un portail de VOD ; à l’occasion de la diffusion d’une série à succès des millions de personnes peuvent vouloir visualiser le même épisode. Même s’ils n’accèderont pas au programme au même instant, il faut pouvoir répondre à des milliers de requêtes à la seconde. C’est pour cela que des groupes de médias peuvent être intéressé par les nouveaux serveurs ultra rapides NVMe d’IBM capables d’assumer simultanément un très grand nombre de requêtes.

M. : On parle de solutions internes ; qu’en est-il des solutions « cloud » ?

J. D. : Il est possible de faire des économies d’échelle importantes avec des systèmes cloud surdimensionnés grâce aux partages de moyens entre les différents clients. C’est une question de rationalisation des coûts et de politique interne : est-il envisageable de déposer des données sensibles sur des serveurs qui ne vous appartiennent pas ! Ce n’est plus de la technique !

M. : Que représentent en termes de coûts ces différentes technologies de stockage ?

J. D. : En informatique les prix évoluent très vite ; il y a dix/quinze ans, un ordinateur de moyenne gamme, accessible à tous aujourd’hui, coûtait environ 1500 €. Les besoins n’augmentent pas aussi vite que l’évolution de la technologie. Seules les grandes sociétés internationales sont toujours plus demandeuses de puissance ; soit pour la France 40 structures.

Jusqu’en 2010 environ, les disques durs magnétiques gagnaient tous les ans à peu près 30 % de capacité à tarif équivalent en renforçant leur densité surfacique. Aujourd’hui pour y arriver on doit changer de technologie, les coûts ne baissent plus que de 7 à 10 % par an. Alors que les besoins en puissance se stabilisent, ceux en stockage augmentent de 30 % par an au niveau mondial.

Pour continuer à augmenter la capacité des disques durs de 3,5 pouces, possiblement jusqu’à 40 à 45 To, il faut changer les têtes de lecture, le coût baissera alors de 5 % par an uniquement. La solution existant depuis 70 ans maintenant c’est la bande magnétique. Comme sur les dix années précédentes, sur les dix prochaines, ce marché va croître de 25 à 30 % avec une diminution équivalente des coûts. Habituellement en informatique, les laboratoires possèdent des prototypes avec deux ou trois ans d’avance ; chez IBM, nous disposons d’un prototype de « tape » prévu pour une échéance de dix ans.

M. : Quels sont les différents types de bandes magnétiques ?

J. D. : La LTO (Linear-Tape Open) est un format ouvert géré par un consortium dont IBM est un acteur très actif. La LTO v8 est sortie fin 2017 avec une capacité de 12 To. IBM propose également le format Jaguar, un peu plus cher et beaucoup plus performant. Les lecteurs IBM TS1160 permettent aux cartouches JE (5e génération) d’avoir une capacité de 20 To. Les deux types de cartouches ne sont pas interchangeables entre lecteurs, mais il est possible de mixer les technologies au sein d’une même solution.

M. : Quel est l’intérêt de pouvoir les mixer ?

J. D. : Cela permet de profiter des performances du Jaguar et du prix du LTO. On mixe aujourd’hui les trois systèmes : la bande magnétique, les disques durs magnétiques et la technologie flash. Étant déconnectée par nature, la bande possède l’avantage d’être imperméable aux attaques informatiques. On est même amenés à utiliser la bande en production, malgré son débit restreint, grâce aux systèmes de fichiers distribués (comme Spectrum Scale) ou aux logiciels « HSM » (hierarchical storage management). On utilise la « tape » dans « le tiers le moins performant » (la partie du stockage la plus lente) avec une gestion logicielle très performante. Pour les solutions de production, la technologie Jaguar est bien plus performante avec des débits en lecture/écriture de 400 Mb/sec. Lorsqu’on doit accéder à de nombreux fichiers, on perd naturellement en performance à cause des temps d’accès. La gestion logicielle permet de les abaisser sensiblement.

Aujourd’hui on accède en trois secondes à un fichier au hasard dans une cassette Jaguar. Dans l’industrie des médias, le Jaguar est préféré pour la production grâce à des solutions de Media asset management (MAM) et de Content storage management (CSM) un peu à la manière d’un HSM. Pour les particuliers, la technologie bande n’est pas intéressante au vu du coût des lecteurs ; même si depuis dix ans ces derniers peuvent être connectés en USB.

La plate-forme externe n’a subi aucun changement, mais la qualité de la bande a fortement évolué. On est passé de la LTO 1 à 8 qui fait 12 To non compressés pour un prix de 130 € (en quantité) soit 11 €/To. Un disque dur de capacité équivalente se négocie un peu plus de 400 €, soit un facteur 3 entre les deux. Pour les gros systèmes de plusieurs Po (pétaoctets), les médias représentent 50 % du prix final. La bande est alors avantageuse. En matière de performances, le disque magnétique se fait distancer par la technologie « flash ».

Ce sont les raisons de la mort certaine du disque dur magnétique. C’est aujourd’hui une question d’acceptation par le marché, toujours plus lent que la technologie. Récemment, IBM a acheté sur une large volumétrie de la « flash » avec un prix au Téraoctet (To) moins cher que le disque dur magnétique ; on pensait que cela n’arriverait pas avant 2022. D’ici peu de temps, en standard, la technologie flash sera moins chère que les disques durs magnétiques.

M. : Un des sujets à aborder est la durée de vie de ces technologies

J. D. : Pas de débats : les bandes proposent de longues durées de vie qui augmentent année après année ; elles sont maintenant composées d’un alliage Baryum Ferrite (BaFe) extrêmement résilient garanti dix ans avec des durées de vie estimées de 25 à 30 ans. C’est un chiffre peu représentatif car vous ne conserverez pas des médias sur des bandes pendant cette durée sans risquer de perdre les lecteurs en capacité de les relire.

Une génération matérielle dure trois à quatre ans ; un nouveau lecteur est rétro-compatible sur deux générations, donc les bandes sont utilisées dix ans en pratique. La durée de vie d’un disque dur est de sept ans environ, dépendant de nombreux facteurs dont la marque et la vitesse, ramenée à trois/quatre ans pour une utilisation quotidienne. Dans ces conditions, ils sont changés régulièrement.

M. : Les médias archivés sur des disques durs mécaniques risquent-ils d’être perdus au bout de quelques années ?

J. D. : C’est la roulette russe ! Il y a deux types de pannes : les casses mécaniques du moteur ou de la tête. Dans ce cas, la seule possibilité de récupération des médias consiste à confier le disque à un réparateur spécialisé : le coût est important et les délais longs.

Le deuxième problème est la corruption des secteurs. L’enregistrement des données se fait par orientation de particules métalliques grâce à un champ magnétique. Avec le temps les secteurs, même non utilisés, vont se démagnétiser. Pour des films vidéo cela aboutit à la génération d’artefacts aléatoires et complètement imprévisibles. En seulement deux années quelques artefacts peuvent être visibles.

On se moque d’un pixel mort rattrapable par les logiciels de récupération de données, mais après quatre ans le risque augmente de manière non linéaire selon la qualité du matériel, le stockage et l’utilisation. On est sur des interactions moléculaires et magnétiques ; il est impossible de gérer au cas par cas toutes les cellules. Aujourd’hui il est conseillé de copier régulièrement ses données sur de nouveaux médias en vérifiant leur intégrité. Une fois que ses secteurs sont corrompus, le disque dur les marque et la capacité du disque diminue.

M. : Et pour les disques SSD ?

J. D. : Sur les disques SSD, les cellules sont des sortes de condensateurs. Au moment du « flash » les cellules HS vont être neutralisées et la capacité du disque va diminuer. Au fur et à mesure des copies, le système va déplacer les données depuis les cellules défectueuses vers des secteurs sains. Les pertes potentielles sont généralement compensées par des logiciels de correction d’erreurs. Les entreprises « critiques » disposent toujours d’une redondance complète des médias. Utilisé intensément un disque peut être détruit en trois à quatre ans ; généralement il dure sept à huit ans, voire plus.

M. : Peux-tu nous préciser les différentes technologies de disques SSD ?

J. D. : Les disques SSD (Solid state drive) sont composés de cellules de flash qui peuvent être de plusieurs types. La cellule SLC (Single level cell) est une cellule à deux états : du courant = 1, peu de courant = 0. Pour augmenter la capacité des disques, on augmente la densité de gravure. La durée de vie de la SLC est sensiblement équivalente à celle des disques durs magnétiques, environ dix ans.

Pour augmenter la capacité, la technologie MLC (Multi level cell) est apparue en 2010. Dans une cellule, on enregistre deux niveaux, soit quatre valeurs de tensions, c’est-à-dire 2 bits. La capacité des disques augmente au carré (pour la même taille) avec une division des coûts par deux. Les cellules sont utilisées de manière beaucoup plus intense. La technologie TLC (Triple level cell) utilise trois niveaux, huit valeurs de tensions ou 3 bits. Il y a trois ou quatre mois est sortie la Quad level cell (QLC – 16 niveaux pour 4 bits) avec une durée de vie encore écourtée.

C’est pour ces raisons que le prix des disques flash s’écroule parallèlement à l’augmentation de la densité, et que l’on peut stocker des petabytes de données dans des serveurs de quelques unités de hauteur seulement. Samsung et d’autres fondeurs travaillent sur des cellules à cinq niveaux PLC (pinta level cell). Les disques durs durent de moins en moins longtemps : dur, dur ! Mais combien de temps ?

Aujourd’hui en moyenne un SSD va durer quatre ans, durée suffisante pour le grand public et les professionnels. IBM a breveté un super logiciel intelligent à l’aide duquel on peut pousser cette durée jusqu’à cinq/six ans. Même si IBM ne développe pas de disques flash, cela ne nous empêche pas de breveter des logiciels pour de nombreuses technologies. En 2018, IBM a vendu pour plus d’un milliard de dollars d’utilisation de brevets

M. : Pourquoi les disques flash s’appellent-ils ainsi ?

J. D. : Sur les disques SSD, les données sont enregistrées par modulation d’un courant enregistré dans les cellules. Une fois le disque entièrement écrit, les cellules qui ont été libérées par l’utilisateur sont marquées mais pas supprimées (il est donc possible de retrouver les données sur un disque dur flash effacé). Il faut alors « reseter » l’ensemble des cellules avant d’écrire dessus à nouveau (les cellules marquées libres n’étant pas vidées). On va alors envoyer la foudre ! ou un flash !

À l’échelle d’un disque dur, la tension d’une douzaine de volts que l’on envoie est équivalente à une mini bombe atomique ! Cela génère tellement de perturbations électromagnétiques qu’on ne peut plus lire ni écrire sur toutes les cellules autour de la cellule flashée pendant deux microsecondes ; c’est de là que viennent les problèmes de durée de vie : à force, les cellules crament.

M. : Ne pourrait-on pas les flasher un peu moins fort ?

J. D. : Le but du jeu c’est de baisser au maximum la puissance du flash, mais il faut un minimum de puissance pour éviter toute corruption. Pour augmenter leur durée de vie, des logiciels intégrés dans les firmwares des disques font de la prévision des zones qui devront être lues ou écrites pour réduire les flashs.

M. : Est-ce le même principe pour les clés USB ?

J. D. : Oui, c’est également de la technologie flash. Aujourd’hui, la durée de vie de ces matériels se compte en nombre de flashs. La SLC est la meilleure, elle peut supporter environ 100 000 cycles de lecture/écriture par cellule quand les cellules multi-niveau n’en supportent que 10 000. D’autres technologies flash arrivent avec d’autres types de firmware.

M. : Est-ce que la mémoire RAM repose sur la même technologie ?

J. D. : Les mémoires RAM sont flashées si elles sont remplies pendant la session de travail. Avec les quantités de RAM actuelles, elles sont très rarement saturées. Quand un ordinateur est éteint, sa mémoire RAM se vide, il y a donc un reset « naturel » sans flash. Si les ordinateurs ne sont jamais éteints comme les serveurs, la durée de vie des mémoires RAM va baisser ; elles sont en pratique changées tous les trois/quatre ans, parallèlement aux processeurs.

M. : On dit souvent qu’il faut éviter de remplir à plus de 80 % un disque dur magnétique. Est-ce vrai ? Et qu’en est-il des disques SSD ?

J. D. : C’est vrai pour le disque dur magnétique. Il utilise un espace temporaire pour la maintenance en récupérant des données utiles afin d’effacer des espaces où sont présents des secteurs entiers de données obsolètes. Sans cet espace libre temporaire les opérations de maintenance sont impossibles.

Les disques durs flash s’en moquent ! De plus les ordinateurs comportent une quantité de RAM de plus en plus importante dans laquelle peuvent être stockées les données pour les opérations de maintenance ; les logiciels ont également évolué. Je dirais qu’on peut aujourd’hui remplir les disques durs magnétiques à environ 90 %. Sur les disques SSD, les systèmes de récupération des données sont gérés directement par leurs firmwares.

M. : Peux-tu nous parler des concepts de stockage online, near-online et stockages froids ?

J. D. : Il s’agit d’une méthodologie en silo utilisée depuis 50-60 ans. On scinde les types de stockage par besoins en performances et coûts. Cela n’a plus lieu d’être aujourd’hui grâce à l’architecture des systèmes, la virtualisation du stockage et les stockages unifiés apparus il y a plus de vingt ans. Le but est de disposer d’un pool de stockage unique visible par l’utilisateur avec un pilotage logiciel des différents stockages adressés en fonction des besoins en stockage chaud (utilisable rapidement avec un bon débit), ou froid (nécessitant un délai pour être rapatrié vers le stockage chaud). Aujourd’hui toutes les entités disposant d’un budget suffisant utilisent cette technologie ; parfois avec leurs propres solutions. C’est le principe du HSM (hierarchical storage management). Les « outsourceurs » (fournisseurs cloud) proposent des services moins chers, mais il y a des choix politiques en fonction de la sensibilité des données. Des entreprises sont prêtes à payer plus cher pour conserver les données chez elles.

M. : Quel est l’impact du stockage au niveau écologique ?

J. D. : Il y a moins de machines dans un data center, vu qu’elles sont virtualisées, distribuées et partagées. Dans tous les cas, l’informatique consomme énormément d’énergie.

M. : La vraie question à se poser est peut-être : pourquoi conserve-t-on autant de données, notamment des médias qui, au final, servent très peu ?

J. D. : La donnée est le nouveau pétrole. En conservant un maximum de données, on peut les analyser via des solutions d’intelligence artificielle de plus en plus performantes. C’est le modèle économique de Google : 90 % de son chiffre d’affaires est issu de la publicité. Ils offrent le meilleur profilage des individus en conservant et analysant toutes les données qui transitent chez eux. Une fois les résultats des analyses obtenues, on conserve les données parce que de futurs logiciels offriront des analyses encore plus poussées. Les données brutes sont comme le pétrole, sauf que ce dernier une fois raffiné n’est plus utilisable.

M. : En quoi la bande est-elle une solution écologique ?

J. D. : D’abord, les cartouches ne consomment pas d’électricité en dehors des phases d’écriture et de lecture, alors que tous les téléviseurs, les boxes et les disques durs consomment lorsqu’ils sont en veille. À petite échelle c’est négligeable, pour des centaines de millions de cartouches qui remplaceraient potentiellement des millions de disques durs, cela représente des millions de kWh. Les bandes magnétiques économisent 95 à 98 % d’énergie par rapport à une baie de disques équivalente ; c’est la technologie qui consomme le moins d’électricité, et de loin. En termes de construction, la technologie des bandes et des lecteurs représente un peu de métal assemblé, beaucoup plus économique que le cobalt et les autres terres rares des processeurs et des technologies « silicium ».

M. : IBM est-il le seul acteur de la bande ?

J. D. : Les librairies sont des grandes armoires automatisées avec des robots qui introduisent les cassettes dans les lecteurs : IBM représente plus de la moitié du marché. L’intelligence de cette technologie se trouve dans les lecteurs. IBM les vend directement ou sous forme OEM.

Parmi nos concurrents qui fabriquent d’autres librairies, certains utilisent des lecteurs IBM avec leurs logos. Pas de débat : à ce niveau les lecteurs sont 100 % IBM. Concernant les cartouches, IBM travaille en collaboration avec Fujifilm et Sony qui ont permis d’énormes avancées.

Aujourd’hui l’évolution est freinée par les limitations d’investissements. Dans de nombreux secteurs, même si vous investissez plus vous ne pourrez pas aller beaucoup plus vite à cause de limites physiques ; ce n’est pas le cas pour la « tape ». IBM pourrait développer des Tapes plus performantes plus vite avec un budget R&D plus élevé. Il faut néanmoins prendre en compte l’équation économique qui nous permet d’être rentable pour pérenniser la technologie.

Article paru pour la première fois dans Mediakwest #34, p.100/105. Abonnez-vous à Mediakwest (5 numéros/an + 1 Hors-Série « Guide du tournage ») pour accéder, dès leur sortie, à nos articles dans leur intégralité.