Le moniteur de profil Telestream MPS-300 analyse les signaux 12G-SDI et IP ST-2110 avec de nombreux modules pour analyser les débits IP, les signaux PTP et les métadonnées © Telestream

Le moniteur de profil Telestream MPS-300 analyse les signaux 12G-SDI et IP ST-2110 avec de nombreux modules pour analyser les débits IP, les signaux PTP et les métadonnées © Telestream

La société avait également invité des représentants de Canal+, M6 et Radio France pour venir partager leurs retours d’expérience lors du déploiement de leurs infrastructures en ST-2110.

Dominique Bergeret, directeur commercial de Telestream pour l’Europe du Sud, a débuté le séminaire par une présentation rapide de Telestream. L’entreprise a été fondée il y a vingt-cinq ans avec deux produits innovants à l’époque : Flip Factory, un workflow logiciel pour traiter les contenus TV sous forme de fichiers pour des opérations répétitives comme le transcodage, la conversion de formats, etc. et ensuite Pipeline, un outil d’ingest pour automatiser et simplifier la conversion des contenus reçus aussi bien en cassette que des signaux live.

Depuis, la société a développé de nouveaux systèmes comme Vantage, une nouvelle solution d’ingest Lightspeed Live capture multi input ( SDI, 2110, SRT, NDI) et a surtout élargi la palette des outils de traitement et d’échanges grâce à l’acquisition de treize sociétés, comme VidChecker ou Ineoquest pour le contrôle qualité et la mesure de flux de streaming, Front Porch Digital ou MassTech Innovations pour la gestion de l’archivage fichiers, et a accéléré sa présence sur le Cloud avec le rachat de la société Encoding.com. En 2019, elle a racheté la division vidéo de Tektronix qui va être au centre des présentations de ce séminaire.

Les nouvelles courbes de transfert du HDR

Yannick Le Dréau, ingénieur d’application chez Telestream, débute sa présentation en rappelant les évolutions techniques récentes dans le domaine de la production vidéo : augmentation de la résolution image en passant de la HD à l’UHD et plus récemment la 8K, élargissement des espaces colorimétriques, augmentation des fréquences de rafraîchissement poussé par le monde du gaming et enfin le HDR (High Dynamic Range). Ces évolutions sont principalement encouragées par la couverture des grands événements sportifs, mais aussi l’essor des services de streaming qui veulent offrir au téléspectateur la meilleure expérience visuelle.

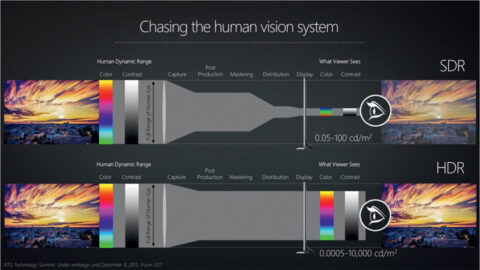

Même si une majorité des programmes est encore diffusée en HD et en SDR (Standard Dynamic Range), la captation est effectuée de plus en plus souvent en UHD et HDR. L’objectif du HDR est d’offrir une meilleure dynamique, en particulier dans les hautes lumières lors de captations en plein soleil ou avec des objets brillants mais aussi afficher plus de détails dans les noirs.

Les caméras 4K récentes offrent une dynamique étagée sur seize stops (ou valeurs de diaphragme). La postproduction, le codage habituel des signaux en SDR, puis la diffusion réduisent cette dynamique à sept ou huit stops, valeurs cohérentes avec la luminosité des écrans classiques limitée à 100 nits (ou cd/m2). Pour coder les images en HDR et profiter de la luminosité accrue des écrans LCD, il faut modifier la courbe de transfert lors du codage des images.

Deux courbes de transfert sont proposées : la courbe HLG, mise au point par la BBC et la NHK, et la courbe PQ (Perceptual Quantization).

La première consiste à reprendre la courbe de gamma traditionnelle pour les valeurs moyennes de luminosité et à l’infléchir dans sa partie supérieure pour mieux prendre en compte les hautes lumières sans les écraser. Elle reproduit les niveaux de lumière à partir de la scène captée et fonctionne indépendamment du niveau lumineux de l’écran y compris ceux de type SDR à 100 nits. Cette courbe est surtout utilisée pour les programmes diffusés en direct.

La courbe PQ, à la base des autres codages HDR comme le Dolby Vision ou le HDR10, est capable de coder des niveaux lumineux jusqu’à 10 000 nits et fonctionne de concert avec l’écran dont elle va contrôler le niveau lumineux en fonction de ses caractéristiques. Elle exige un traitement spécifique pour coder au mieux une large gamme de niveaux lumineux avec un nombre limité de bits (10 ou 12) et est donc mieux adaptée à la diffusion de contenus enregistrés comme ceux disponibles en streaming.

La gestion des métadonnées

Pour documenter le contenu HDR, les ancillary data sont mises à contribution en précisant la courbe de transfert utilisée, les métadonnées employées et le format des images. Pour cela, on utilise les quatre user data word disponibles dans la trame SDI et associés à chacune des courbes, SDR, HLG ou PQ, l’espace colorimétrique (BT.709, ou BT.2020), le nombre de bits (10 ou 12) de codage et la dynamique, Narrow Range ou Full Range.

Si le train SDI est mal renseigné, l’ensemble du workflow mis en place va traiter des contenus selon des paramètres qui ne correspondent pas à ceux d’origine et fournir un rendu et une colorimétrie dégradés. Dans les flux ST-2110, ces informations sont inscrites dans le fichier SDP associé à la vidéo qui en spécifie tous les paramètres.

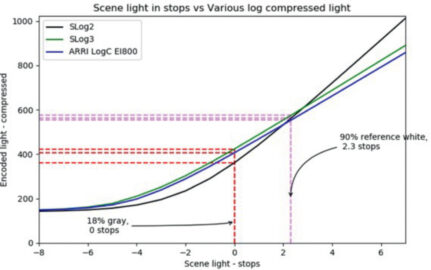

Multiplication des courbes de transfert

Les fabricants de caméras ont aussi apporté leur pierre à l’édifice de la complexité des codages et des workflows HDR. Pour offrir la meilleure qualité d’image, chacun d’eux a mis au point une courbe de transfert spécifique pour tenir compte des performances de son capteur. Et c’est ainsi que sont apparus les diverses courbes comme le S-Log2 ou S-Log3 chez Sony, le C-Log de Canon ou d’Arri. Cette disparité a pour conséquence qu’un niveau lumineux fournira des niveaux électriques différents selon la caméra. Le gris à 18 % sert toujours de point de référence, mais il n’est plus possible de comparer des signaux de caméras différentes avec une échelle linéaire en mV ou en pourcentage comme avec le SDR basé sur une courbe de gamma identique.

Pour résoudre ce problème, Telestream a choisi de graduer ses waveform monitor en « stop » avec comme référence 0, le niveau lumineux du gris à 18 %. En prenant en compte les courbes de transfert des différentes sources à étalonner, cette nouvelle échelle de mesure en stop facilite l’évaluation de la correction à apporter.

Prudence avec les conversions multiples

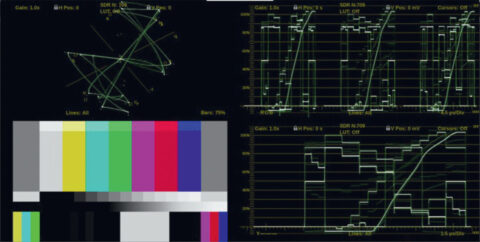

La mise en place de workflows hybrides et la multiplication des combinaisons de codages et de paramétrages exigent souvent des étapes de conversion. Celles-ci se traduisent par la création de LUT (Look Up Tables) pour transformer les valeurs des composantes couleur selon leurs espaces de référence. Ces LUT sont plus ou moins complexes, depuis de simples tables unidimensionnelles jusqu’à des conversions très élaborées avec des LUT 3D. Les LUT sont parfois choisies et paramétrées en fonction de leur rendu et donc de critères esthétiques. Elles sont basées sur des conversions mathématiques avec des approximations de calcul qui, au fil des traitements (surtout si elles interviennent en mode aller/retour), peuvent créer des artefacts parfois visibles et fugitifs avec un étalement particulier des valeurs lumineuses ou des contrastes.

Dans ce but, le SMPTE a mis au point une mire spécifique composée de mires de barres à 75 % et à 100 %, associées à des zones de valeurs très proches du noir et du blanc maximal ainsi qu’une rampe de gris allant du noir au blanc. L’examen de cette mire sur le moniteur de profil Prism permet de vérifier rapidement les écarts de valeur et surtout les non-linéarités induites par les traitements de conversion.

Yannick Le Dréau a illustré ses propos avec trois exemples de conversion : le premier avec une perte de détail dans les noirs, un deuxième avec les détails dans les noirs préservés mais, par contre, une rupture dans la linéarité et enfin un troisième avec un défaut encore plus accentué et une réponse moins bonne dans les mires de barres. Une démonstration qui illustre parfaitement que le contrôle de la qualité image doit s’appuyer à la fois sur des critères esthétiques mais qu’il est impératif de vérifier le profil des signaux pour éviter l’apparition de défauts.

Le PTP, élément essentiel des architectures ST-2110

La seconde présentation de l’après-midi était consacrée au déploiement des nouvelles infrastructures en ST-2110. Yannick Le Dréau débute sa conférence par un rappel sur l’organisation de la norme ST-2110 dont l’objectif est de transférer les architectures classiques en SDI dans le monde des réseaux IP.

Mais la partie la plus importante de son intervention était consacrée à l’inter-synchronisation des sources avec la gestion du protocole PTP. Dans l’univers SDI, la fourniture d’un signal de synchronisation à l’ensemble des équipements sous la forme d’un black burst ou d’une synchro tri-level est un élément fondamental pour assurer la stabilisation des signaux vidéo et leur commutation propre à l’antenne. Dans le monde des réseaux, les trames de données IP sont par essence asynchrones et sont transmises en fonction des contraintes du réseau et de sa charge.

Il explique que « lorsque nous allons passer d’une infrastructure SDI à une architecture réseau tout IP, les activités de production restent identiques. Seul le cœur du système va migrer d’une grille vidéo à une infrastructure IP avec une commutation des flux depuis une source vers une destination. Il est toujours nécessaire de distribuer une référence temporelle à l’ensemble des équipements et pour le ST-2110, c’est le protocole PTP (Precision Time Protocol) qui a été choisi. »

Deux « master clock » mais une seule référence à la fois

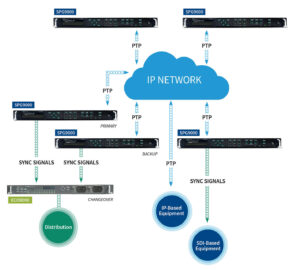

Il reprend le schéma classique de la distribution du black burst à partir de deux générateurs de synchronisation référencés sur l’horloge GPS d’une constellation de satellites. Deux unités sont nécessaires pour basculer de l’une à l’autre en cas de dysfonctionnement, ce qui est assuré par une unité de Change Over.

Dans une architecture IP, on retrouve un principe similaire avec deux générateurs « grand master clock » référencés aussi sur l’horloge GPS, et qui fournissent chacun un signal PTP. Il a été mis au point par l’IEEE pour distribuer une référence horaire ultra précise, par exemple dans l’industrie pour piloter des robots ou dans la finance pour valider des transactions boursières ultra-rapides. Le SMPTE a repris ce protocole et l’a adapté aux besoins de la vidéo avec la norme ST-2059.

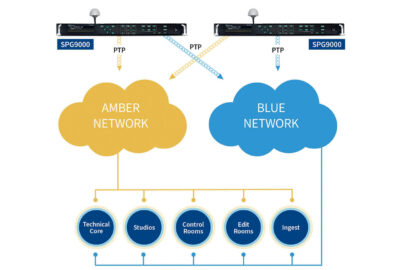

Comme dans toute infrastructure critique, l’ensemble des actifs réseau sont dédoublés et répartis dans deux réseaux distincts A et B, repérés par les couleurs rouge et bleu. Comme il n’y a pas de change-over pour les réseaux IP, les informations PTP fournies par les deux grand master clock doivent être distribuées via les actifs du réseau A et du réseau B à l’ensemble des équipements pour assurer une redondance complète. Le protocole PTP distribue cette référence aux sources de contenu qui vont l’insérer dans les flux vidéo et audio avec des marqueurs à la fréquence de 90 kHz pour la vidéo et 48 kHz pour l’audio AES. Pour compenser les retards et la gigue des signaux IP, tous les récepteurs sont équipés d’une mémoire tampon pour absorber ces variations et remettre en phase les signaux vidéo et audio selon la référence qu’ils reçoivent également via leur port réseau.

Chaque « end device » doit être paramétré avec le nom de domaine qui est l’endroit logique où sera extraite l’information temporelle. Si le nom de domaine n’est pas correctement renseigné, l’équipement sera incapable de trouver sa référence horaire et restera asynchrone par rapport au reste de l’installation.

Le cas des infrastructures hybrides

Yannick Le Dréau détaille d’autres recommandations : « Le grand master clock est l’horloge ultime du réseau et il ne peut y en avoir qu’une seule active dans l’installation. Si deux grand master clock sont actifs en même temps, c’est qu’il y a un problème quelque part. Il faut analyser leurs fichiers Log et vérifier quels autres événements ont pu faire perdre le dialogue entre les deux machines. »

Il faut également veiller à la parfaite symétrie des réseaux A et B pour réduire les retards de transmission entre les deux cheminements. Des fonctions dans le moniteur de profil Prism de Telestream sont dédiées à la mesure des écarts temporels au niveau des entrées des end devices mais aussi pour évaluer l’influence de la gigue des paquets IP.

À ce jour, il n’existe encore aucune infrastructure intégralement déployée en ST-2110 car il subsiste toujours des équipements ou des îlots SDI. Il faut donc leur distribuer un signal black burst pour assurer leur synchronisation. Plusieurs architectures hybrides sont possibles. Un couple de générateurs de synchro SDI asservis aux grand master clock fournissent un signal de black burst distribué dans l’ensemble de l’installation. Comme leur cheminement sera assez différent de celui du PTP, des décalages peuvent apparaître surtout si les installations sont réparties sur une aire étendue. Telestream préconise plutôt d’implanter un générateur de synchro SDI au niveau de chaque sous-ensemble SDI, lui-même asservi sur le PTP desservant cette zone. Un outil intégré dans le Prism permet d’aligner rapidement les deux références, PTP et black burst, pour remettre tous les signaux produits en parfait synchronisme.

RETOURS D’EXPERIENCE

Canal+

Pierre Maillat est en charge des études et des architectures à la DPTO de Canal+. « L’élément déclencheur pour le passage à l’IP ST-2110, c’est le déménagement du siège du groupe avec pour objectif de regrouper les moyens de production des chaînes payantes et des chaînes gratuites sur un seul site », explique-t-il.

Canal+ a déjà une expérience dans le domaine de l’IP puisqu’en 2016 le site de production Canal Factory avec ses quatre plateaux avait été réaménagé avec des technologies IP mais en 2022-6 et 2022-7. Cette première phase a permis également de tester des opérations en remote production.

Le projet du transfert du siège a été mené avec un planning très serré avec mise à disposition des locaux en mars 2022 et mise à l’antenne entre juillet et septembre. L’opération a débuté par le transfert de la rédaction de CNews et d’une cinquantaine de salles de montage puis l’aménagement de quatre studios avec leurs régies et du nodal.

Parmi les multiples difficultés incontournables dans un projet d’une telle ampleur, Pierre Maillat en relève une première série autour des fibres optiques et des modules QSFP car, pour lui, « le passage du 10 Go au 100 Go ne se fait pas nécessairement sans douleur ». Autre difficulté, d’ailleurs soulevée par les autres participants à la table ronde, c’est l’importance des outils de supervision pour obtenir une remontée des alarmes et dysfonctionnements. Pierre Maillat note « qu’il est important de monitorer tous les end devices. On a parfois des effets domino avec des choses assez surprenantes et il faut pouvoir analyser dans le détail le fonctionnement interne des machines ».

M6

Fabrice Tauzies est responsable de l’ingénierie/support de la diffusion au sein du groupe M6, il est en charge principalement de tout le périmètre de la diffusion depuis l’arrivée des médias jusqu’à leur diffusion. En 2017, s’est posée la question du renouvellement de la régie finale âgée d’une dizaine d’années. Elle héberge aujourd’hui douze chaînes avec une extension possible pour accueillir neuf nouvelles chaînes.

« Au début du projet, nous avons commencé par dessiner une architecture à la fois en SDI et en IP. Mais nous ne voulions pas repartir sur une technologie SDI vieillissante pour au moins dix ans. » M6 a choisi la solution Magnum d’Evertz qui propose une architecture similaire à celle des grilles vidéo et qui fournit les équipements réseau. Il résume cette approche avec une boutade : « Avec la solution d’Evertz, on met de l’IT dans du broadcast, tandis qu’avec les autres constructeurs, on met le broadcast dans l’IT. »

Après avoir fait la bascule vers l’IP en 2019, il exprime sa grande satisfaction : « Nous ne sommes pas du tout mécontents d’être partis sur cette technologie qui nous apporte énormément d’avantages. Nous avons beaucoup économisé sur la “glue” et sur le câblage. Autre amélioration importante, le nombre de pannes qui a été divisé par cinq. »

Cette transition a néanmoins été un challenge important à relever car les technologies et les produits sont encore récents, pas tout à fait secs. Il relève aussi des difficultés au niveau de l’interopérabilité entre les constructeurs. « Nous avions l’habitude de travailler avec des liaisons RS-422 ou des API. Les solutions offertes par le NMOS ne sont pas encore totalement finalisées. » Il cite le cas d’un serveur vidéo qu’il a voulu passer de trois à quatre canaux et cette simple extension a nécessité une reconfiguration complexe dans l’orchestrateur. « La détection des pannes est plus complexe aussi. En SDI, il suffit d’aller sur un patch avec un outil de contrôle pour détecter le défaut. En IP, il faut pousser l’analyse plus loin pour trouver la cause du dysfonctionnement. »

Radio France

Étienne Roulette, Responsable de projets en charge du déploiement de l’infrastructure ST2110 à Radio France et Pierre Gras, Expert ST2110, responsable du maintien en conditions opérationnelles de l’ infrastructure ST2110, sont venus relater le passage des infrastructures de la Maison de la Radio en ST-2110. Celles-ci relient une cinquantaine de studios dont l’interconnexion était basée sur une grille datant d’une douzaine d’années.

Étienne Roulette détaille les phases de l’opération : « En 2017, il a été décidé de la remplacer et d’explorer les possibilités offertes par le ST-2110. En 2018, un POC centré sur cette technologie a été mis en place et le projet a réellement démarré en 2019 par le choix de deux intégrateurs, l’un pour l’audiovisuel associé à un second pour les réseaux. En 2020, nous avons mis en place une plate-forme de qualification qui nous a permis de comprendre ce qu’était le ST-2110 et de déverminer la technologie et les équipements. »

L’un des constats fait par les deux responsables concerne les divergences d’interprétation de la norme chez les fabricants. Pierre Gras explique que « le nombre de façons de faire sont multiples au niveau de la production et que ces derniers ne peuvent pas penser à tout. Le dialogue avec les architectes et les intégrateurs est très important. Il ne faut pas hésiter à aller au bout des choses et ne pas laisser de zones d’ombre ». Ils rappellent tous les deux que la formation est un élément clef et qu’elle a représenté un volet important de l’opération.

Autre sujet sur lequel est revenu Pierre Gras, c’est celui de la supervision : « La plupart des équipements font du SNMP ou du syslog. Nous avons une plate-forme SCOM de Microsoft qui récupère toutes ces données et, derrière, on a une surcouche qui les met en forme avec un aspect plus graphique pour suivre l’état de santé de l’ensemble des équipements. Ensuite avec DCNM de Cisco, j’ai une vision complète de l’état de l’ensemble des flux qui circulent sur le réseau. »

Article paru pour la première fois dans Mediakwest #53, pp. 130-136