Les équipements de production live traditionnels sont organisés et raccordés à une grille de commutation vidéo (ou routeur vidéo). Les sources comme les caméras, les lecteurs vidéo ou les générateurs graphiques lui envoient en permanence les images, même si aucun équipement ne les reçoit. Les destinations câblées en sortie (vers les mélangeurs, les enregistreurs, la régie finale, et le monitoring) sont en permanence à l’écoute, prêtes à traiter le signal sélectionné au niveau du routeur. Mais, elles aussi, restent passives. Tout le travail d’aiguillage des signaux est effectué au niveau de la grille sous les ordres d’un clavier ou d’un contrôleur de supervision.

Avec le basculement en tout IP ou en SVIP (pour Studio Video over IP, selon le dernier sigle en vogue), on pourrait imaginer que ce schéma d’organisation classique reste immuable avec un remplacement des câbles vidéo coaxiaux par des câbles réseaux (fibres optiques ou paires torsadées) et de la grille de commutation par un routeur réseau sophistiqué. Or les choses sont juste un peu plus complexes.

La grande force des réseaux IP réside dans leur indépendance aux formats et résolutions vidéo, et à leur capacité à multiplexer des données de natures différentes sur une même liaison grâce à la transmission par paquets et non par des signaux continus. Les données sont identifiées au niveau des paquets avec l’adresse de l’émetteur et celle du récepteur. Contrairement aux câblages vidéo classiques, l’émetteur et le récepteur ne sont pas identifiés par le port physique du routeur sur lequel ils sont raccordés.

Les fonctions internes d’un routeur IP aiguillent les données via les adresses contenues dans ces paquets. On aurait pu imaginer conserver ce dispositif pour effectuer la commutation des sources vidéo. Mais quand leur nombre augmente, ce travail d’aiguillage prend de plus en plus de temps et ralentit donc les commutations. D’autre part, les données vidéo sont réparties dans les paquets sans aucune relation temporelle avec le timing du balayage vidéo. Il est donc difficile d’effectuer une coupe propre à l’image en se basant uniquement sur les paquets.

Commuter les signaux au niveau du récepteur

Plusieurs stratégies pour la commutation des sources avaient été évoquées lors des premières présentations des équipements SVIP. La commutation au niveau du routeur IP a été abandonnée au profit de la commutation au niveau de la destination (destination switching). La distribution d’une même source vers plusieurs destinations est assurée par une diffusion multicast de son contenu en s’appuyant sur les infrastructures conformes au protocole IGMP (Internet Group Management Protocol).

Dans un réseau IP traditionnel, une grande majorité des liaisons sont de type unicast, un utilisateur interrogeant et dialoguant de manière isolée avec une source de données dans une communication point à point (ou peer to peer). Pour la distribution en live de contenus multimédias, la diffusion en mode multicast évite la multiplication des flux, sous réserve que l’ensemble des équipements actifs soient compatibles IGMP, ce qui est le cas de la majorité des infrastructures et matériels récents.

Pour établir une commutation vidéo via un routeur IP, le contrôleur qui supervise l’infrastructure, et donc le routeur IP, récupère les caractéristiques des sources et des destinations et la nature des signaux qu’elles traitent, via le protocole de reconnaissance des équipements NMOS (Networked Media Open Specifications) élaboré dans le cadre des travaux de l’AMWA (Advanced Media Workflow Association) et bientôt standardisé sous le sigle IS-04. Il envoie une commande de type « join » à la destination pour lui dire de se connecter sur le flux multicast émis par la source grâce à son adresse multicast. La liaison est ainsi établie via le routeur IP.

Pour effectuer une commutation propre entre deux sources, le contrôleur envoie cette commande vers la destination. Celle-ci ne peut pas changer à la volée l’adresse de la source sur laquelle elle doit se brancher, car celle-ci s’effectue au niveau d’un paquet. Or l’organisation des paquets n’est pas liée à la structure du balayage vidéo et cela provoquerait une saute d’image. Avant d’effectuer la commutation, la destination va se connecter au flux multicast de la nouvelle source, mettre en mémoire ses premiers paquets, repérer l’instant du top de synchro verticale (en principe les deux signaux sont synchrones et les paquets contiennent des repères précisant les références horaires du signal PTP) attendre le top de la synchro verticale pour effectuer la commutation entre les deux flux.

Cette commutation effectuée, le contrôleur envoie une commande « leave » à la destination pour qu’elle se désabonne de la source initiale. Tout ce mécanisme induit un retard d’une image par rapport à l’envoi de la commande, ce qui peut perturber les équipes techniques. Il est donc prévu des mécanismes de commutation rapide avec risque de sautes d’image pour des opérateurs qui ont besoin d’une réactivité immédiate comme les ingénieurs de la vision. D’autre part, pendant un court instant, la destination reçoit simultanément deux flux vidéo, ce qui double le débit lui arrivant. Il faudra tenir compte de cette contrainte lors du dimensionnement de l’architecture du système de production.

Un cœur de réseau redondant

En se basant sur le principe du câblage d’un routeur vidéo traditionnel, le passage au tout IP conduit à le remplacer par un cœur de réseau central unique. Mais pour éviter les risques de pannes, il est impératif de le dédoubler. La fiabilité n’est pas la seule raison à prendre en compte. Ces équipements exigent des mises à jour pour le firmware et les configurations d’exploitation. Avec un système redondant, elles pourront être exécutées en alternance.

Même si cette double architecture offre des performances excellentes et une très haute disponibilité, le raccordement direct avec double attachement de l’ensemble des sources et destination rend le câblage important et augmente le nombre de ports à prévoir sur les deux cœurs de réseau. D’autant que la tendance est de les équiper de ports 100 Gb/s, ce qui les rend plus onéreux.

Une architecture alternative est préconisée en créant deux niveaux de commutateurs. Le premier au niveau de chaque baie d’équipements qui accueille un switch d’agrégation, en général équipé de 48 ports à 10 Gb/s auxquels sont raccordés les divers matériels de production. Ce switch dénommé TOR (pour Top Of the Rack) va regrouper les signaux venant ou destinés aux équipements de la baie dans des flux de 40 ou 100 Gb/s qui, eux, sont raccordés aux cœurs de réseaux via deux ou quatre liaisons. Cela conduit à des cœurs de réseaux de taille plus limitée en nombre de ports.

Les caractéristiques et les performances de ces switches TOR correspondent à des matériels plus classiques et donc moins onéreux. Sur la base des prix moyens du marché, un constructeur estime qu’actuellement le coût moyen d’un switch « spine » 40 Gb/s ramené à chaque port est sept fois plus elevé que celui d’un commutateur « leaf » 10 Gb/s.

Une étude détaillée des débits

Une étude détaillée des débits doit être menée en fonction des formats d’images, lesquels ont une incidence sur les débits engendrés. Si la production travaille en 1080i, les débits unitaires par port sont de 1,5 Gb/s, le total des 48 ports équipés d’une liaison unique conduit à un total de 72 Gb/s. Deux liens d’agrégation à 40 Gb/s peuvent convenir. Pour des signaux vidéo 1080p, le débit unitaire de chaque liaison passe à 3 Gb/s, ce qui donne un total de 144 Gb/s. Il faut alors soit passer à des liens d’agrégation de 100 Gb/s, ou bien, si on conserve des liens à 2 x 40, il faut limiter le nombre de ports exploités sur le switch TOR à 26 liaisons sur 48. Si on monte à l’UHD, le débit unitaire grimpe à 12 Gb/s.

Avec des ports d’agrégation de 2 x 40 Gb/s, on est restreint à six liaisons raccordées sur le switch TOR et on sous-emploie totalement ses capacités de 48 ports. Avec une liaison vers le cœur à 2 x 100 Gb/s, on raccorde jusqu’à seize équipements. D’où l’importance des travaux autour des codecs de compression à faible latence, comme Jpeg2000, Tico ou VC-2, pour transporter les images UHD en réduisant le débit de 12 à 3 Gb/s par liaison.

Cet exemple très simple ne tient pas compte d’autres éléments ou paramètres de calcul comme le nombre de liaisons par port dans le cas d’une conversion IP <- > SDI, la prise en compte des allers-retours selon le type de machines, parfois fortement dissymétriques pour certaines, ni le doublement temporaire du débit consécutif à la gestion du clean switch vidéo, comme expliqué ci-dessus.

Ce travail de dimensionnement de l’architecture IP est absolument primordial pour optimiser les caractéristiques des actifs réseau, la répartition des équipements avec ceux raccordés via un switch TOR ou ceux reliés directement au « spine », le débit théorique et réel de chaque liaison et en définitive le coût total de cette infrastructure. Une erreur de conception pourra aboutir à des situations de blocages du réseau ou à une impossibilité d’extension des capacités de production.

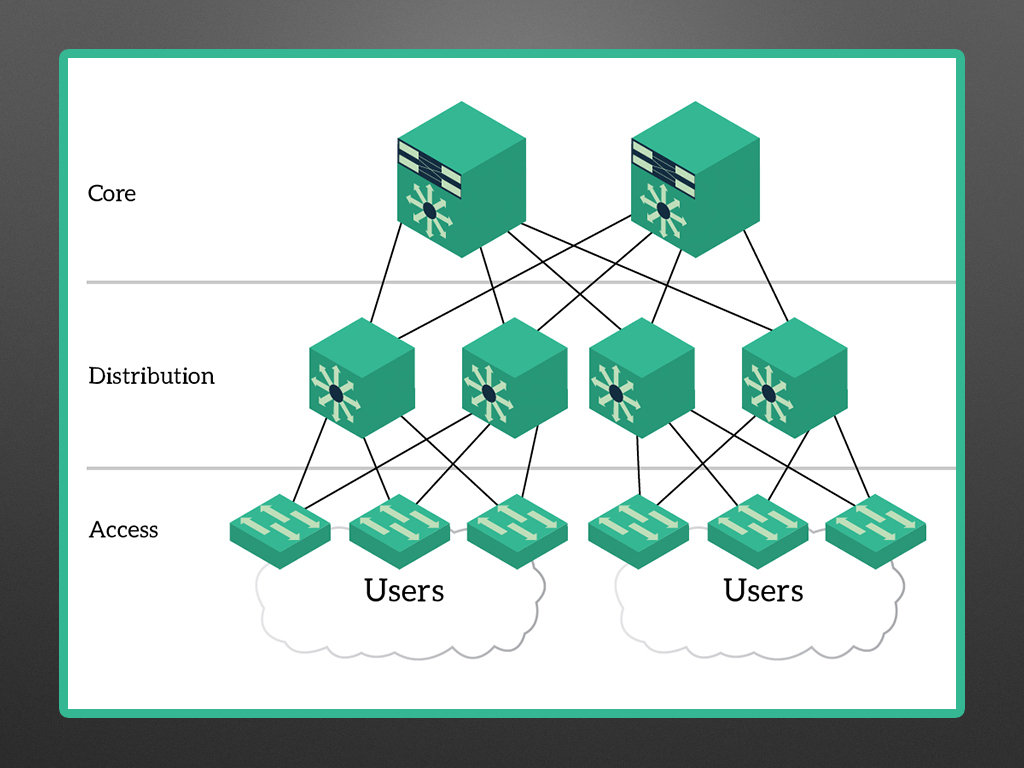

Passer du spanning tree au spine leaf

Deux autres points essentiels à définir lors de la conception du réseau IP de production live concernent la topologie du réseau et la redondance des équipements. Les réseaux classiques implantés dans les entreprises pour la gestion et les outils de communication sont organisés en trois niveaux : le cœur de réseau (core), point central essentiel vers lequel convergent tous les échanges, des switchs de distribution ou d’agrégation qui desservent des zones spécifiques, bâtiments ou services, et enfin les switchs locaux, de bordure ou d’accès sur lesquels se connectent les postes terminaux avec une distance maximale de desserte de 90 mètres.

Pour les activités essentielles et les équipements et postes de travail qui ne doivent souffrir d’aucune coupure, on prévoit un double attachement qui offre une redondance du service en cas de rupture d’un câble ou de panne d’un équipement. En conséquence, les paquets de données peuvent emprunter plusieurs chemins au gré des tables d’adressage gérées par les switchs. Cela peut provoquer des congestions avec des données circulant en boucle. Pour éviter cela, des mécanismes de gestion des ports, avec définition d’une route prioritaire et d’une route de secours, ont été mis au point sous le terme général de « spanning tree ». Si ce protocole est encore pleinement exploité, il a montré ses limites dans les gros data centers, lorsque de gros volumes de données sont échangés et que leur timing doit être très précis.

Les constructeurs d’équipements réseau ont imaginé une autre architecture dénommée « spine leaf ». L’architecture réseau ne comprend alors que deux niveaux avec au minimum deux cœurs de réseaux, le spine (tronc ou colonne vertébrale) et le niveau leaf (les feuilles) pour les switchs de desserte. Ces derniers sont reliés à chacun des core switchs par une liaison directe.

Les mécanismes internes du protocole spine leaf (géré en couche 3, au lieu de la couche 2 pour le spanning tree) sont conçus de manière à ce que les temps de transmission des données soient identiques, quel que soit le cœur par lequel elles transitent. Cette architecture permet d’étendre plus facilement les capacités du réseau en ajoutant d’autres « spine » ou d’autres « leaf » si les volumes de données distribuées dépassent les capacités de départ. Tous les systèmes de production live sur IP sont architecturés selon le « spine leaf » avec seulement deux niveaux de commutation.

Le rôle du standard SMPTE 2022-7

Ce mécanisme de cheminement redondant est renforcé grâce au standard SMPTE ST 2022-7, dénommé « Seamless Protection Switching ». Il précise les mécanismes qui permettent à une source d’envoyer deux fois le même flux vidéo selon deux chemins distincts. À l’arrivée, l’équipement de destination sélectionne l’un des flux, paquet par paquet, et commute automatiquement de manière propre (hitless switching), sur le second chemin si le premier est interrompu ou envoie des données dégradées. C’est la combinaison d’une redondance des équipements actifs, d’une topologie « spine leaf » et des mécanismes du ST 2022-7 qui garantissent une transmission fiable des signaux vidéo dans un environnement IP en éliminant une très grande partie des aléas de la transmission par paquet.

Pour l’instant, la majorité des équipements de production sont encore dotés d’entrées/sorties SDI avec connecteurs coaxiaux. Lorsque des équipements récents disposent d’interfaces IP pour les signaux vidéo, celles-ci sont disponibles en nombre limité. Le basculement vers une infrastructure en tout IP n’est donc pas encore possible. Les constructeurs proposent donc des interfaces de conversion IP <-> SDI. Comme pour les switchs d’agrégation évoqués plus haut, elles seront installées en tête de chaque baie d’équipements pour rendre plus claire l’organisation de l’infrastructure et simplifier son exploitation. Cette approche élimine les câblages entre les baies et facilite ainsi les évolutions. Une baie recevra donc en partie haute un switch d’agrégation relié d’un côté aux deux cœurs de réseau via des liens redondés, et de l’autre les liaisons IP desservant soit les équipements en direct, soit des châssis de conversion SDI <-> IP avec éventuellement des cartes de processing.

Avec sa plate-forme de routing et de traitement GV Node, Grass Valley enrichit cette approche puisqu’elle regroupe à la fois dans un châssis modulaire le switch d’agrégation vers le cœur de réseau avec douze ports 40 Gb/s, des fonctions de routage SDI et IP (jusqu’à une capacité locale maximale de 144 x 144 signaux 3G-SDI), des fonctions de processing et également un multiviewer. Ce regroupement de fonctions en tête de chaque baie allège d’autant les liaisons vers les cœurs de réseau.

De son côté, Embrionix met en avant sa solution de châssis d’agrégation de modules SFP. Avec la taille réduite des modules SFP, un simple châssis 1U assure à la fois les conversions SDI/IP de 96 signaux dans des modules SFP de taille réduite, et l’agrégation des signaux IP vers les cœurs de réseau. D’après ses responsables, cette solution offre un encombrement réduit, une consommation électrique moindre et plus de souplesse pour tenir compte des évolutions vers des matériels offrant plus de ports IP. Il suffit de changer un module SFP de conversion SDI/IP par un module d’interface pour fibres optiques.

Ces quelques exemples démontrent qu’avec le basculement vers les signaux IP, les architectures des équipements de production doivent être profondément révisées, avec des règles de conception tenant compte des débits des signaux et une implantation différente des matériels. Dans un réseau classique d’entreprise, les équipements actifs sont répartis sur trois niveaux : cœur, distribution et accès.

* Article paru pour la première fois dans Mediakwest #23, p.72-74. Abonnez-vous à Mediakwest (5 nos/an + 1 Hors série « Guide du tournage) pour accéder, dès leur sortie, à nos articles dans leur totalité.