Après avoir fortement pénétré le marché grand public, le Cloud computing fait une percée saisissante depuis deux ans dans le monde de l’entreprise et aussi dans la filière des industries audiovisuelles. Pour autant, il est impératif de prendre garde à quelques pré-requis avant d’opter pour une solution de Cloud computing. Tentons une approche avec ce bref tour d’horizon centré sur les services de stockage.

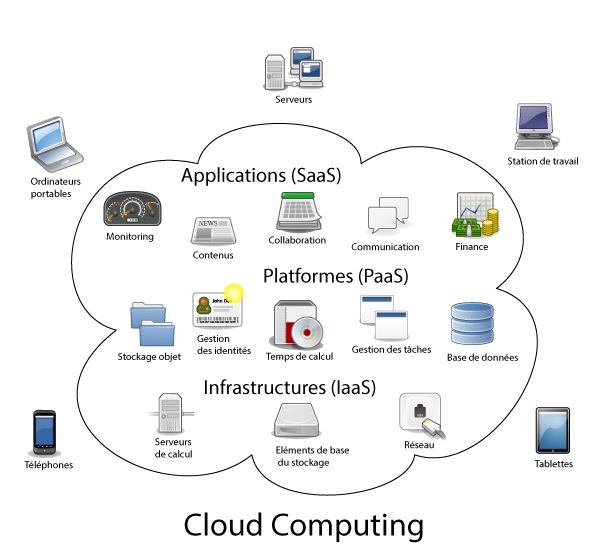

Le Cloud computing est un modèle à la fois technologique et marketing qui permet l’accès en ligne, via le réseau Internet et à la demande, à des ressources informatiques et/ou des services applicatifs. Il englobe trois grandes typologies de services : l’IaaS (Infrastructure as a Service), Le PaaS (Platform as a Service), Le SaaS (Software as a Service), représentées généralement sous la forme d’une pyramide en haut de laquelle on trouve le SaaS et en bas l’IaaS. Dans ce modèle de développement et consommation informatique, c’est la strate la plus haute, le SaaS, qui crée l’impulsion d’achat et la valeur ajoutée de l’ensemble, tandis que la PaaS et l’Infrastructure as a Service sont souvent reléguées au rang de facilité, même si nous verrons par la suite que ce n’est pas si simple et qu’au moment du choix de sa plateforme Cloud, il est impératif d’avoir une cohérence d’ensemble des autres critères.

Le Cloud inaugure surtout une nouvelle façon de concevoir et de consommer l’informatique et s’inscrit dans une logique plus profonde d’externalisation (et de dématérialisation progressive) des systèmes d’information. Le National Institute of Standards and Technology lui attribue volontiers cinq caractéristiques de base : un ensemble de ressources accessibles de partout en réseau (Internet ou réseau privé) ; la mutualisation de ressources éclatées entre une multitude de serveurs répartis à travers le monde (d’où le terme de « nuages ») ; un libre-service à la demande sans interaction avec le fournisseur ; un accès rapide et souple à ces ressources ; et une facturation souple (grâce à divers tableaux de bord en ligne).

Le Cloud roi de l’OPEX

Dès le départ, la promesse du Cloud est d’exonérer l’entreprise d’un investissement (parfois lourd) en achat de licences et de matériels informatiques, en lui proposant de réaliser des dépenses opérationnelles (OPEX, Operational Expenditure) facilement mesurables et qui peuvent s’étaler dans le temps, plutôt que d’investir dans des immobilisations (CAPEX, Capital Expenditure) et un investissement initial en matériel et logiciel souvent lourd. Ainsi, l’imputation de l’informatique en OPEX libère des lignes de budget pour des investissements plus centrés sur le cœur de métier de l’entreprise.

D’autre part, une offre d’abonnement Cloud prévient l’entreprise cliente de tous les coûts cachés auxquels elle aurait dû faire face en choisissant une solution informatique traditionnelle, telles que la mise à disposition des infrastructures, l’exploitation, la maintenance, les mises à jour, les sauvegardes ou encore l’assistance, le tout régit par une garantie de service de la part du fournisseur. Autre atout du Cloud pour les finances d’une entreprise, les durées d’engagement peuvent varier d’un prestataire à l’autre et en fonction des offres mais, globalement, les contrats Cloud dépassent rarement une ou deux années et peuvent même être « sans engagement » de durée.

Fort de ce premier constat purement financier, on comprend que le mode de commercialisation du Cloud computing ouvre le domaine de tous les possibles pour des structures de petite taille comme les start-ups qui en sont les premières consommatrices, car elles y voient un moyen de concentrer leurs efforts sur leur nouveau service disruptif sans trop se soucier de l’infrastructure informatique sous-jacente qui permet à l’application de fonctionner ou, en tout cas, à proportion du nombre de clients qu’elles gagnent.

La connectivité : un facteur décisif dans la disponibilité du service Cloud

Avant de migrer ses ressources informatiques dans le « Cloud », il convient de s’assurer d’une condition sine qua non de cette migration : la qualité de son accès Internet ou de son VPN. En effet, le réseau sur lequel va reposer l’accès aux services Cloud est crucial. La disponibilité et la performance du réseau (bande passante, temps de réponse, latence, coupures, etc.) ont un impact direct sur la perception finale des utilisateurs sur la qualité du service virtualisé. L’entreprise cliente doit donc s’assurer d’avoir un taux de disponibilité adapté à la criticité de l’activité ou du logiciel confié à l’éditeur Cloud. La généralisation des infrastructures Télécom haut débit, notamment en France, ainsi que le développement d’offres par les opérateurs permettant d’augmenter la qualité et la sécurité de leurs réseaux, contribue à encourager les entreprises à évoluer vers le Cloud. Quelques acteurs incluent ainsi le volet réseau dans leur offre avec, par exemple, des solutions de type VPN permettant de renforcer la fiabilité des accès et de proposer un service de bout en bout.

Les termes parfois « nébuleux » des contrats dans le « nuage »

De manière générale, les clauses des contrats de services Cloud concernent principalement la disponibilité, la sécurité, la confidentialité et le support. Les garanties relatives à la confidentialité des données, à leur traçabilité ainsi qu’à celle opérations et à la qualité de services sont à définir clairement, notamment pour les applications critiques ou manipulant des données à caractère personnel, stratégique ou liées à une quelconque législation. En matière de conformité règlementaire, il est important de noter que c’est bien l’entreprise cliente qui reste juridiquement responsable des données stockées dans le cloud, le fournisseur de la plateforme agissant en tant que sous-traitant. La réversibilité des données doit elle aussi être encadrée avec précision dans le contrat qui lie tous les acteurs concernés. Également à surveiller : les engagements de disponibilité, la fréquence des sauvegardes, ainsi que le rôle respectif des différents acteurs (exemple : éditeur, hébergeur, intégrateur et opérateur réseau). Enfin, l’intégration et la personnalisation des services sont un enjeu important pour l’entreprise cliente, car elle doit s’assurer, avant de faire son choix, que les solutions SaaS envisagées couvrent bien toutes les fonctionnalités métiers attendues par les utilisateurs.

La plupart des contrats que l’on conclut avec un fournisseur de services dans le Cloud reposent aussi sur un niveau de SLA (Service Level Agreements), c’est-à-dire sa promptitude à répondre à une requête du client, à remettre en service une application défectueuse ou encore à s’engager à délivrer des données dans un format et un délai exploitable à la fin du contrat. Dans ce registre, l’ensemble des observateurs du Cloud s’accordent à dire que les acteurs de ce nouveau marché s’engagent assez peu, chacun fixant un pourcentage de SLA dans ses Conditions Générales de Ventes. Le SLA repose sur un calcul de la disponibilité des ressources informatiques relativement standard que l’on retrouve résumé dans le tableau ci-joint et qui s’obtient en divisant la durée durant laquelle un équipement ou un système est opérationnel par la durée totale durant laquelle on aurait souhaité qu’il le soit. Ce ratio s’exprime sous forme de pourcentage. Notons que la restitution des données stockées dans le Cloud, notamment des fichiers source, doit être examinée avec attention, car elle est souvent payante et fournie dans un format non immédiatement exploitable.

La sécurité : atout majeur du Cloud ou talon d’Achille ?

Si les particuliers et les start-ups en ont vu rapidement le gain d’usage pour stocker et partager des données ou pour utiliser des applications facilitant le quotidien, le monde de l’entreprise et, a fortiori, celui de l’audiovisuel et du cinéma, qui manipule des données sensibles, met logiquement plus de temps à se pencher sur ce nouveau paradigme économique et technique, en particulier du fait des questions de sécurité.

Pour autant, l’argument du manque de sécurisation des contenus dans le Cloud tient de moins en moins face à des réponses techniques émergeantes comme le Cloud privé (le Cloud privé est un nuage de ressources informatiques isolées de manière étanche du reste d’une plateforme Cloud) et les architectures hybrides séparant Cloud privé et public avec des passerelles limitées à certaines applications uniquement. Les grands comptes de l’industrie, y compris dans l’audiovisuel, l’ont bien compris d’ailleurs, puisqu’ils sont de plus en plus nombreux à auditer désormais leur infrastructure informatique pour savoir s’il ne serait pas judicieux de déporter tout ou partie de leur ressource informatique dans un Cloud privé.

L’exemple du Groupe Publicis est à ce titre significatif, car cette multinationale, qui compte 60 000 personnes dans le monde et de nombreux bureaux délocalisés, a pris le virage du Cloud computing il y a déjà trois ans en s’appuyant sur sa propre infrastructure informatique installée dans quatre datacenters différents (deux en Europe, un aux États-Unis et un en Asie), afin de garder le contrôle sur ses données et éviter tout risque de piratage durant la conception des campagnes publicitaires. De la sorte, les développeurs de Publicis disséminés sur la planète peuvent allumer ou éteindre à leur guise des ressources informatiques à l’intérieur de ce Cloud privé en fonction des projets gérés par chaque agence locale. Pour autant, le groupe Publicis a aussi des besoins en matière de Cloud public qu’il a basé sur les serveurs d’Amazon et il est en train de mettre en place des passerelles entre ces deux « nuages ».

Le stockage objets, gage d’évolutivité et de souplesse

L’explosion du volume des données qui transitent via les réseaux se traduit par une évolution des interfaces et des protocoles de stockage des données. Au cours des dernières années, les protocoles de stockage NAS, qui imposent de savoir sur quel serveur ou nœud un objet est stocké, sont progressivement remplacés par le « stockage objet » qui répond aux nécessités d’accéder à des volumes exponentiels de données non structurées et dispersées géographiquement. Il existe de multiples systèmes de stockage objet comme Atmos d’EMC, Amazon S3 d’AWS, Windows Azure Storage, OpenStack Swift, Scality, Data Direct Network Le stockage objet propose une approche fondée sur un espace de noms composé de paires clé/valeur. Les objets y sont en général organisés dans un espace d’adressage plat et éventuellement dans des conteneurs de plus haut niveau parfois appelés « buckets » (littéralement des seaux). D’une certaine façon, on peut comparer le stockage objet à un système de consigne. Lorsqu’un client dépose un objet, il reçoit un ticket, mais ne se préoccupe pas de l’endroit où sera stocké son objet. Sa seule préoccupation est qu’en échange du ticket il pourra retrouver son objet par la suite. Une des caractéristiques intéressantes des systèmes objet est qu’ils permettent d’associer un ensemble de métadonnées très riches aux objets stockés. Ainsi, il est possible de retrouver un « objet » par une recherche sur ces métadonnées, par un identifiant unique ou par un système de clé/valeur (key/value store). Le stockage objet permet d’obtenir un coût au gigaoctet très compétitif. Il est ainsi bien adapté au stockage d’un grand nombre de données à faible valeur ou au stockage de fichiers de gros volume… comme les fichiers vidéo. De plus en plus de fournisseurs de services Cloud proposent le stockage objet, mais pas tous. À vous de vous pencher sur cette option…