Hier et aujourd’hui : nouveaux venus… et disparus !

Année 2012, an zéro de la captation cinématique VR ? En tout cas une année charnière qui voit la sortie officielle du rig Freedom360 sur la base de six GoPros Hero3, premier rig qui permet la captation d’une image 360 couvrant 100 % de la surface de la sphère. Les puristes se souviendront bien sûr des rigs « ladybug » et autres « cinq caméras autour d’un bâton », avec lesquels il était impossible d’obtenir une sphère complète. Le résultat : un « trou » au niveau de la base caméra (le nadir), souvent masqué par un logo ou un patch plus ou moins élégant. La famille des rigs Freedom360 s’est agrandie depuis, avec des versions tropicalisées (Freedom360 Explorer) et dédiées au livestream (Freedom360 Broadcaster). Ces rigs sont toujours commercialisés et très populaires parmi les utilisateurs, bien que concurrencés aujourd’hui par des caméras 360 « all in one » plus pratiques à utiliser. Trois ans plus tard, la sortie de la caméra Nokia Ozo est annoncée : avec son design avant-gardiste, elle préfigure l’apparition des caméras 360 que l’on connaît aujourd’hui. En 2015, cette petite sphère gris anthracite révolutionne la captation VR de par ses capacités cinématographiques ; elle est proposée avec une suite logicielle de prévisualisation et de stitching performante.

Mais… Nokia annonce fin 2017, soit deux ans après son lancement, l’arrêt de la production et de la commercialisation de sa caméra, après avoir pourtant drastiquement baissé son prix et annoncé la sortie d’une version 2. L’arrivée de plusieurs concurrents dans ce marché de niche a peut-être été fatale à la Ozo : en effet, durant la période 2015-2017, Jaunt puis le concept Google Jump sont eux aussi plébiscités par les cinéastes, surtout aux États-Unis. Ces deux caméras (Jaunt One et GoPro Odyssey), toutes deux construites sur la base d’un rig radial, permettent une captation stéréoscopique et une image assemblée de très haute définition (8K x 4K en stéréoscopie), et bénéficient d’un workflow novateur proposé par leurs fabricants respectifs : le stitching (assemblage des différentes caméras) dans le cloud avec Jaunt Cloud et Jump Assembler.

Aujourd’hui, l’offre matérielle se rationnalise et s’adapte au marché. Certains acteurs de la première heure sont toujours là : GoPro vient de sortir Fusion, sa caméra « action cam » 360, Google propose la caméra Yi Halo en lieu et place de l’Odyssey et continue à promouvoir la cinématique VR en tant que producteur de contenus (on peut citer en exemple la coproduction avec Discovery d’une série documentaire en 360 de 38 épisodes, Discovery TRVLR). De nouveaux fabricants « agitateurs » sont venus troubler ce marché, parmi lesquels certains semblent tirer leur épingle du jeu : Insta360, Zcam et Kandao. Ces trois acteurs chinois proposent des caméras « all-in-one » de bon rapport qualité prix, avec une gamme étendue, aussi bien pour les professionnels que pour les amateurs avertis. Et surtout, leurs outils sont compatibles avec certaines des nouvelles techniques de captation volumétrique 360 qui vont très vite révolutionner la cinématique VR : Depthmaps et Light eld.

Nuages de points, lasers et photogrammétrie : anciens outils, nouveaux usages.

La notion de capture de notre environnement existe depuis des décennies avec les techniques de scanner et de photogrammétrie. Ces méthodes, loin d’être nouvelles, sont déjà utilisées dans de nombreux champs d’applications scientifiques et industriels comme la médecine, l’architecture et le BTP, l’archéologie, l’agriculture, le contrôle d’ouvrages d’art, ou les sciences de la terre. Toutes ces connaissances, tous ces matériels peuvent-ils aider les « cinéastes VR » dans le souci de capter fidèlement la réalité ?

Nous sommes allés à la rencontre de Frédéric Gourdet, VR production specialist chez Neotopy, également géomaticien de formation. Il va nous éclairer sur les différentes techniques de captation et leur possible utilisation dans la cinématique VR.

Mediakwest : Les deux méthodes de captation volumériques bien connues des industriels et des scientifiques sont la photogrammétrie et le scan laser. Peux-tu en quelques mots nous éclairer sur ces techniques ?

Frédéric Gourdet : La photogrammétrie est une méthode de mesure par assemblage photographique. À l’origine, elle est utilisée dans l’établissement des plans et cartes topographiques à partir de photographies aériennes, puis ensuite via les photos satellite, mais aujourd’hui, une des applications possibles de la photogrammétrie est la modélisation en 3D d’un environnement ou d’un objet, à partir de simples photographies, grâce aux progrès technologiques. En effet en photographiant sous toutes les coutures un objet, on va obtenir plusieurs images de celui-ci depuis plusieurs points de vue. En assemblant ces photographies à la manière d’un puzzle grâce aux points de concordances entre les images, et en prenant en compte la parallaxe, on va être capable, à l’aide d’un logiciel spécialisé, de mesurer des distances, d’en déduire le relief de l’objet, de l’environnement et donc de modéliser en 3D l’objet, l’environnement. C’est le principe qu’a choisi la société Matterport qui, en l’associant avec la technologie de scanner infrarouge, propose un outil simple et rapide pour réaliser des visites en réalité virtuelle pour l’immobilier.

Pour le scan laser, on peut parler de la technologie Lidar (qui signifie Light Detection and Ranging). C’est une technologie de pointe qui permet de mesurer des distances grâce à l’analyse du temps entre l’émission et la réception d’un signal laser. Récemment cette technique a fait parler d’elle, car elle a notamment permis de découvrir, en scannant la jungle du Yucatan depuis un hélicoptère (le rayon laser traverse la canopée et nous livre le relief et la topographie du terrain caché par la forêt), les ruines d’une des plus grandes cités mayas jamais découvertes. Il aurait fallu des mois, voire des années, à une équipe de géomètres pour avoir les mêmes résultats en utilisant des techniques de relevés classiques, à cause de l’inaccessibilité du site. À noter qu’il existe également d’autres méthodes pour scanner des environnements ou objets, comme celle utilisée par exemple par Google avec le projet Google Tango qui combine les méthodes de la photogrammétrie avec des données provenant de capteurs du type infrarouge, accéléromètre et gyroscope. Cependant la finalité n’est pas la même, ces techniques combinées sont utilisées de plus en plus majoritairement pour scanner notre environnement proche afin de pouvoir le restituer en temps réel et diffuser des contenus en réalité augmentée.

M. : Ces techniques peuvent-elles transformer la cinématique VR ?

F. G. : Avec l’essor de la réalité virtuelle ces dernières années, on a vu apparaître deux types de contenus immersifs pouvant être visionnés dans des casques : d’un côté les vidéos 360 et de l’autre les contenus 3D temps réel, type jeux vidéos. Dans le premier cas, on a un rendu réaliste puisqu’il s’agit d’une captation du réel par des caméras 360, mais le spectateur n’a que trois degrés de liberté. Autrement dit, il peut tourner sa tête et regarder où il veut mais il ne peut se déplacer par lui-même dans l’image. Il est prisonnier du point de vue de la caméra.

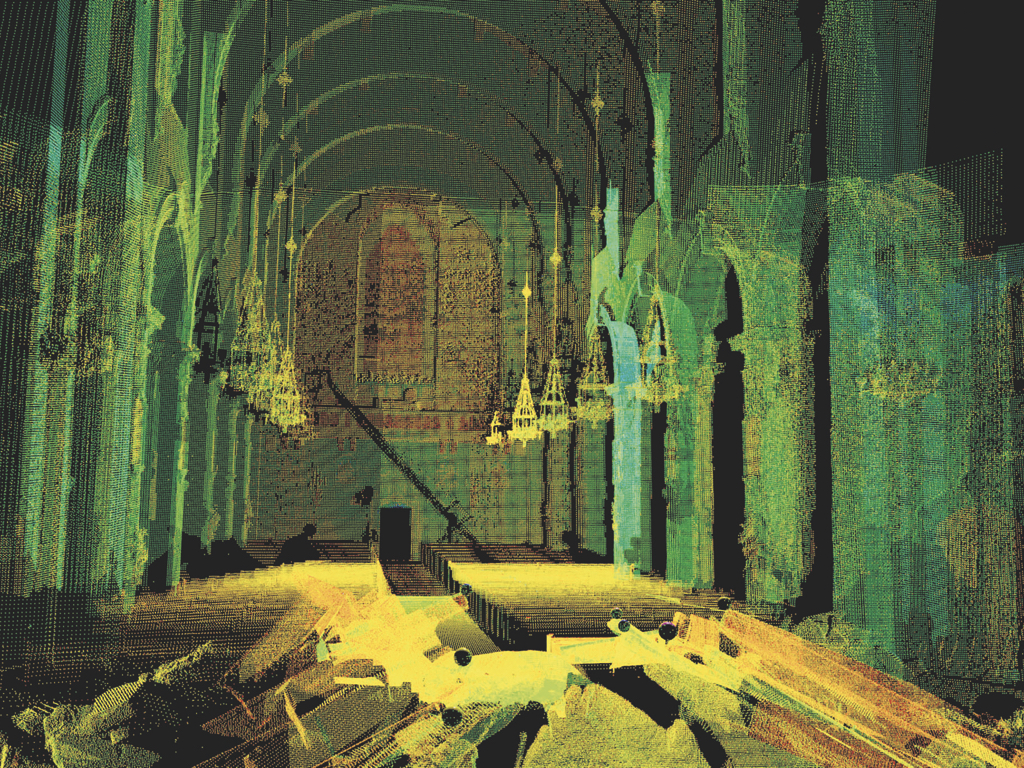

Dans le second cas, on a un environnement virtuel en 3D temps réel recréé par ordinateur qui permet au spectateur/utilisateur les six degrés de liberté. On peut donc regarder où l’on veut, se déplacer, s’accroupir… on bénéficie d’une expérience qui se rapproche de la réalité. Mais cette liberté totale a un coût : ces expériences sont très gourmandes en puissance de calcul, donc aujourd’hui les environnements virtuels sont le plus souvent modélisés avec des textures simplifiées ou minimalistes, restituant un rendu peu réaliste. Bien sûr il existe aujourd’hui quelques expériences VR avec des modélisations photoréalistes issues de Scan 3D ou de photogrammétrie (l’application « Realities » sur HTC VIVE par exemple), c’est un début. Demain, avec la combinaison de toutes ces techniques et l’amélioration des nouveaux outils de captation, les fameux six degrés de liberté (6DoF) seront monnaie courante dans les expériences cinématiques VR.

Depthmaps, Lightfield : le futur, c’est maintenant !

La notion de six degrés de liberté est-elle donc le graal que tous les créateurs d’expériences cinématique VR attendent ? Oui, du point de vue des fabricants d’outils de captation : ceux-ci se concentrent sur les technologies qui, in fine, permettront aux usagers d’évoluer plus librement dans les expériences proposées. Au sein de Neotopy, Frédéric, grâce à ses compétences en géomatique, travaille actuellement en étroite collaboration avec le fabricant de caméras 360 Kandao sur la génération automatique de « depthmaps », et leur exploitation en temps réel dans un player immersif. Les résultats sont très prometteurs aujourd’hui sur les photographies : grâce à un workflow rapide et léger, on peut littéralement se « promener » de manière très réaliste grâce au rendu des parallaxes en temps réel, à l’aide d’un casque Oculus Rift, HTC Vive ou compatible Windows MR. La depthmap (carte de profondeur), c’est- à-dire la représentation en niveaux de gris de la profondeur d’une image, est une technique qui existe depuis longtemps dans le secteur des effets spéciaux. Elle permet d’incruster des images sans fond vert, par exemple, ou d’effectuer un changement de profondeur de champ a posteriori. Mais dans le cas de la captation cinématique VR, comment ça marche ? La technique repose sur la captation stéréoscopique et l’utilisation des informations de disparité entre deux (ou plusieurs) lentilles. La formule est simple : profondeur = 1/disparité. En effet, plus la distance entre la caméra (l’œil) et le sujet est grande, plus la disparité entre les deux images captées apparaît comme minimale : c’est l’effet parallaxe de notre vision stéréoscopique. L’image 360 est donc captée par une caméra composée de suffisamment d’optiques (six dans le cas des caméras Kandao), puis stitchée avec un puissant algorithme permettant d’extraire deux « sphères », une pour chaque œil. Au cours de ce processus, la depthmap est automatiquement générée, extraite, et disponible pour la suite du travail de postproduction. On peut alors utiliser cette information de depthmap « traditionnellement » pour les FX, mais aussi pour « activer » l’option 6DoF dans un player et un casque adéquat. Dans ce cas, la notion de cinématique VR prend tout son sens et l’expérience immersive est (presque) réaliste. Aujourd’hui, les principaux fabricants de caméras 360 professionnelles proposent ce type de technologie. Cela est rendu possible en partie par la technologie de « deep learning » utilisée par les algorithmes, et bien sûr les progrès dans la puissance de calcul GPU. Mais les six degrés de liberté (6DoF) proposés par la technologie depthmap ont des limitations : lors de la captation, la caméra est fixe. Donc la simulation des parallaxes est limitée à quelques degrés dans l’espace et on « sort » vite de l’immersion si nos déplacements à l’intérieur de la cinématique sont trop importants. D’autres procédés de captation sont-ils plus qualitatifs ?

La captation Light Field, par exemple, fait en ce moment beaucoup parler d’elle, notamment via la société Lytro qui propose des caméras et des outils de rendu 3D utilisant cette technologie aux professionnels.

Remontons un peu le temps pour constater que ce procédé existe depuis…1908 ! Cette technologie appelée également « plénoptique », est basée sur une matrice de micro-objectifs qui captent l’information de profondeur du champ lumineux, c’est-à-dire l’intensité lumineuse d’une scène comme le font les appareils photographiques traditionnels, mais aussi la direction que prennent dans l’espace les rayons lumineux. Des données de couleur, de profondeur et de direction sont donc associées à chaque pixel « capturé ». Les opérations de traitement d’habitude effectuées au moment de la captation, comme la mise au point par exemple, peuvent désormais se faire en postproduction ! La technologie a d’abord été implémentée par Lytro sur des appareils photographiques destinés au grand public comme le Illum sorti en 2014. Puis sont apparues deux caméras destinées uniquement aux professionnels : La Lytro Cinema et la Lytro Immerge.

La première est spécifiquement utilisée pour capturer des images destinées aux effets spéciaux. La seconde est conçue pour la cinématique VR. La sortie de sa version 2.0 en décembre 2017 a fait grand bruit. Composé de 95 caméras, cet outil est capable de capter un angle de vue de 120 degrés en une seule passe (contre 90 degrés pour la version 1), donc de capturer une « vidéo » 360 volumétrique en trois rotations.

La Lytro Immerge n’est pas qu’une caméra : c’est un système complet qui associe hardware et software, capable de fournir après traitement une image stéréoscopique de résolution 10K par œil ! Le système se compose de la caméra, d’un serveur qui stocke et processe les datas (qui « développe » en quelque sorte l’image volumétrique en associant informations de direction et d’intensité de la lumière), d’un logiciel de compositing qui permet d’associer en volume les images tournées et les images issues de logiciels de CGI, et enfin d’un lecteur Light Field spécifique pour les casques de réalité virtuelle supportant la technologie 6DoF. Mais les ingénieurs de Lytro ne s’arrêtent pas là ! La sortie du Lytro VT pour « Lytro Volume Tracer » permet aux créateurs de scènes, décors et objets 3D d’effectuer un Light Field rendering : l’avantage de la liberté de déplacement de la VR 3D temps réel associée à la qualité d’un moteur de rendu photoréaliste… certainement le futur de l’expérience immersive. Mais Lytro devra désormais compter sur un concurrent dans le domaine de la captation Light Field : Le fabricant Insta360, déjà très présent dans le domaine de la captation 360, vient d’annoncer la création d’un prototype de caméra utilisant cette technologie. Peut-être à un prix plus accessible aux créatifs ?

La virtualité va-t-elle dépasser la réalité ?

Pouvoir s’immerger et se déplacer en temps réel dans un film, c’est désormais possible grâce à ces nouvelles techniques de captation. Mais il y a plus : bientôt, grâce aux progrès rapides des algorithmes d’intelligence artificielle, le scénario va se modifier et s’adapter en fonction de nos réactions, de nos émotions. Rendez-vous dans la « matrice » ou « l’oasis » de Ready Player One…

Les caméras Kandao sont à la vente et à la location chez Visual Impact.

* Article paru pour la première fois dans Mediakwest #26, p. 38-40. Abonnez-vous à Mediakwest (5 numéros/an + 1 Hors-Série « Guide du tournage ») pour accéder, dès leur sortie, à nos articles dans leur intégralité.