Parmi ces nouveaux acteurs, est-il déjà possible de distinguer les nouvelles étoiles qui proposeront enfin des outils de création plébiscités par les artistes et qui provoqueront des expériences encensées par le public ?

Cet article propose des éléments de réponse, en considérant notamment les travaux de l’Academy sur l’ACES (Academy Color Encoding Specification) en cours de standardisation SMPTE (Society of Motion Picture and Television Engineers). Les résultats de ces travaux définissent un concept de gestion de la couleur conçu par

des experts du cinéma, basé sur un flux de production pour l’industrie des images animées dans son ensemble.

L’essentiel sera de ne jamais perdre de vue l’objectif fondamental de cette démarche : offrir les meilleures possibilités créatives aux techniciens et aux artistes, ainsi qu’une qualité d’expérience esthétique mémorable aux spectateurs.

Évolutions du paysage audiovisuel et conséquences

L’expérience du divertissement audiovisuel peut être vue selon deux angles complémentaires et indissociables : le contenu et l’équipement qui le restitue, incarnés par les outils au service de la création et de l’intention artistique, et par les équipements destinés à restituer cette intention. Ce postulat doit être posée à chacune des

étapes des processus de fabrication, de distribution et de restitution d’un contenu.

L’engouement pour les grands gamuts de couleur (wide gamut) et pour l’augmentation des capacités de luminosité (peak and average brightness, contrast ratio) des matériels d’affichage (display) n’a pas cessé de croître ces derniers mois. Il a été amplifié par l’arrivée du relief stéréo en projection numérique (notamment

pour compenser la déperdition d’intensité due aux lunettes relief) ainsi que par celle des tablettes et autres périphériques de lecture ou d’affichage mobile (que l’on veut notamment utiliser dans des conditions d’éclairage très lumineux, en extérieur par exemple).

De nombreux écrans 4K grand public commencent à être disponibles sur le marché intégrant conversion 2K vers 4K, nombre de primaires/composantes des couleurs d’affichage et variantes technologiques au niveau du panneau d’affichage comme le rétroéclairage (backlight). L’accroissement de la cadence d’affichage devient également une fonctionnalité courante dans les téléviseurs grand public, non sans artefacts suivant les implémentations, les modes, les contenus. Concernant l’expérience en salle, on pourrait aussi citer les résultats des premières projections laser présentées lors des derniers NAB (National Association of Broadcasters).

Ces progrès ont été grandement stimulés par l’accessibilité à de nouvelles technologies d’affichage (OLED, direct backlight, local dimming, etc). Une question ressort cependant devant tant de prolifération : comment ne pas perdre le consommateur final entre les messages et autres logos marketing et la véritable expérience ? De fait, comment l’intention créative peut-elle être réellement valorisée sur un display 4K et HFR ?

Du point de vue de la création cinématographique, le recours aux résolutions 4K et supérieures est motivé par la plus grande flexibilité qu’elles offrent dans l’ajustement des plans et le détail de l’image à traiter. L’utilisation du

Slow Motion et du High Frame Rate vient aussi compléter cette double course à l’amélioration recherchée dans la qualité de la projection mais aussi dans la qualité de l’image qui peut être traitée en post-production (exemples récents : les dernières réalisations de James Cameron et de Peter Jackson, utilisant des prises de vues en 48p, avec une distribution en 2K mais une production et une post-production en 4K).

Mais l’argument 4K seul ne suffit pas, il y a plusieurs dimensions à la notion d’amélioration sensible de la résolution perçue : la fréquence des images, la dynamique du signal (dynamic range) et l’espace de couleurs d’affichage (color gamut). Imaginer plus de détails dans les zones sombres (pour l’expression d’un visage qui apparaît dans l’ombre), l’utilisation de points beaucoup plus lumineux (pour l’intensité de certains effets spéciaux), un meilleur rendu de certaines matières comme le métal par rapport à la lumière, une utilisation plus fine entre sources de lumière et lumières réfléchies. À travers ces exemples, est-il possible d’imaginer comment

utiliser ces outils pour enrichir encore plus l’histoire, accentuer l’immersion, produire des effets encore plus spectaculaires, sans parler nécessairement de photo-réalisme, et de toute façon avec le même objectif de plus grande satisfaction et plaisir esthétique du spectateur ?

Si la distribution vers les salles est plutôt bien maîtrisée grâce aux spécifications DCI (Digital Cinema Initiatives), une plus grande rigueur devient possible pour la diffusion avec les équipements grand public, en s’appuyant par exemple sur l’architecture IMF (Interoperable Master Format) et les spécifications de l’ETC (Entertainment Technology Center).

Le monde de la production télévisuelle change lui aussi avec la publication par l’ITU-R d’une recommandation pour le format Ultra HDTV dont le déploiement pourrait intervenir dans les prochaines années. Ce format introduit des résolutions 4K à 60p voire 120p pour la production TV, un color gamut plus large, supérieur au Rec709 et un signal représenté sur 10 ou 12 bits.

Un nouveau schéma de compression (HEVC, High Efficiency Video Codec) est sur le point d’être standardisé et autorisera la distribution de tels formats de manière économiquement viable. Enfin, un dernier élément concerne l’élaboration en cours de la révision 2.0 du standard d’interface audio/vidéo HDMI, avec un très probable alignement sur ces mêmes travaux ITU-R UHDTV.

S’adapter au coeur du tournant

Brève chronique de l’arrivée du numérique dans les studios

L’usage très répandu des caméras numériques (HD, 2K, 4K mais aussi d’appareils photos numérique haut de gamme) est un phénomène qui est venu s’insérer progressivement dans l’évolution numérique déjà bien entamée en amont de la chaîne de production (numérisation sous forme de fichiers des rushes argentiques après la prise de vue) et en aval (projection numérique et plus généralement diffusion des oeuvres numériques sous formes de fichiers). La numérisation des rushes 35 mm ou des prises de vue vidéo HD s’explique par un besoin de cohérence des procédés de fabrication dont certains s’appuient depuis longtemps sur des outils logiciels, notamment pour la création d’effets visuels numériques (matte-painting, animations 3D, compositing…).

La numérisation plus tardive du tournage a, de son côté, engendré des mutations spécifiques, dont les plus emblématiques sont liées à l’étalonnage numérique, apportant de nouvelles contraintes mais aussi de nouvelles possibilités créatives.

L’apparition des premières caméras numériques n’a pas toujours été anticipée par les différents studios de post-production et laboratoires. Cela est notamment dû à la très grande diversité et compétitivité des différents fabricants d’appareils de prises de vue, dont certains se positionnent de manière très originale par rapport

aux autres. Les techniciens de tournage et de post-production ont dû prendre en main ces nouveaux matériels et trouver des solutions pour traiter les nouvelles images, tout en respectant les intentions artistiques en amont et en aval.

Les difficultés techniques et opérationnelles, inhérentes à cette transformation en profondeur des façons de travailler, accentuent la nécessaire interopérabilité des formats et des procédés.

L’une des conséquences particulièrement visible de cette évolution a été le recours aux LUTs de tournage et la mise à disposition d’outils (sur les caméras directement ou via des équipements spécifiques – les « gamma boxes ») pour créer ces LUTs.

Une LUT (abréviation de Look Up Table) est une table de correspondance permettant d’associer une couleur à une autre couleur. Elle permet de remplacer un calcul mathématique gourmand par une simple opération de consultation d’une table. Il s’agit d’une concession entre efficacité et précision.

Les chefs opérateurs et premiers assistants se sont appropriés progressivement ces nouveaux outils numériques de tournage et ont commencé à donner une intention colorimétrique affirmée à la prise de vue, tout en entendant retrouver en post-production ce « pré-étalonnage » qu’ils avaient vu on-set.

Au début de la transition argentique vers digital, les images arrivaient en fin de chaîne sans que l’on connaisse forcément les pré-processus qui avaient été effectués à la prise de vue, d’où la difficulté de les traiter correctement. Et souvent la création de LUTs au tournage par des personnes ne maîtrisant pas encore tous les tenants et aboutissants en termes de dynamique et de couleur, pouvait provoquer des difficultés en post-production (traçabilité des LUTs par rapport à la multitude des rushes, cohérence avec le reste du pipeline de fabrication…).

L’adaptation s’est donc faite au coup par coup – parfois dans la douleur, en créant des outils à partir d’autres outils que l’on savait déjà manipuler (par exemple en ajoutant une option dans une brique logicielle développée en interne). Des solutions fragiles au début mais progressivement consolidées par des utilisations successives.

Puis les logiciels adaptés à ces nouveaux processus sont arrivés, renforcés par les possibilités offertes par les processeurs graphiques temps réel (GPU). Cette évolution itérative donne parfois l’impression que ces outils sont en version « beta » (version de test) permanente.

Progressivement, le besoin de flexibilité est devenu crucial, tant l’approche technique liée à chaque projet devenait différente, renforçant l’originalité créative revendiquée, elle, depuis toujours.

L’idée de la mutualisation des ressources se fait ressentir de plus en plus fortement : « cloud computing » et « business process management » font également ici leur apparition, comme dans presque tous les domaines de l’industrie.

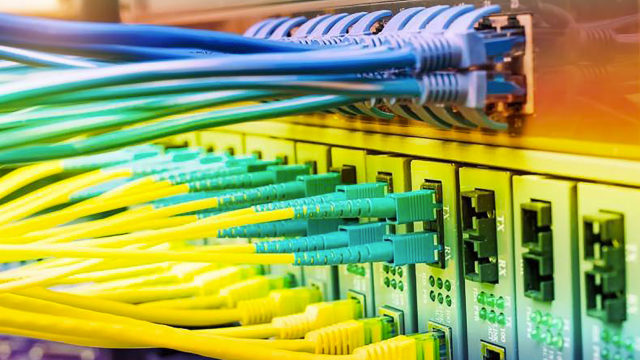

Pour s’adapter à ces changements, les infrastructures de production en studio et de postproduction ont évolué et ont renforcé dans ce domaine – celui du cinéma numérique – la mise en place d’une architecture informatique dédiée : la bande de base a cédé la place au fichier, le câble coaxial HD-SDI à la fibre Ethernet, le hardware au software. NAS (Network-Attached Storage) et autres SAN (Storage Area Network) ont fait leur apparition aux côtés des bandes magnétiques qui sont le plus souvent devenues des cassettes LTO pour les sauvegardes dans

l’environnement de post-production.

La quantité de données à manipuler est de moins en moins un problème, qu’il s’agisse de transfert ou de traitement des données. Une exception cependant : la production on-set qui demeure un défi car elle nécessite un recours à des fichiers de travail ou de visualisation de plus petite taille. On a aujourd’hui des temps de conformation / rendu 4K équivalents à ce qui était nécessaire pour le 2K l’année dernière (source HPA 2012).

La sécurité des données reste néanmoins au coeur de l’équation : fiabilité du support disque et/ou flash par exemple, sans parler de la nécessité de mettre en place des politiques de sécurisation d’accès aux contenus, à toutes les étapes du partage de ces données.

Nouveau pipeline

Aujourd’hui ces problématiques numériques sont adressées par l’ensemble des acteurs de l’industrie. Divers logiciels (Hiero de The Foundry, Scratch d’Assimilate, Clipster de DVS, Open-Cube d’OpenCube technologies…) permettent d’extraire les images des formats de fichiers souvent propriétaires des caméras, et de les traiter ou de les transformer en s’appuyant sur les métadonnées associées aux images. Sans l’obtention de ces métadonnées, une conversion via un logiciel tiers-partie ne serait pas possible. Au fil de la post-production, des LUTs permettent de passer d’un espace de couleur à un autre et d’afficher les images correctement (LUTs de

transformation ou LUTs d’affichage).

Le 2K qui était un challenge à une époque est aujourd’hui largement maîtrisé et il n’est pas rare de traiter des productions en 4K, voire à des résolutions supérieures.

Dans le pipeline de création, les standards sRGB / REC709 sont encore très utilisés, y compris pour des productions Cinéma, bien que pour ces dernières l’espace de couleur DCI tende à remplacer le sRGB.

Néanmoins, la question se pose toujours : a-t-on besoin des couleurs supplémentaires apportées par le gamut DCI-P3 ? Est-ce toujours efficace de les utiliser ? Interrogations qui trouveront leurs réponses assez rapidement tant la motivation à maîtriser le rendu colorimétrique de bout en bout de la chaîne est forte.

Dans le cas de productions cinématographiques, l’étalonnage numérique peut encore se faire dans l’espace de codage Cineon (i.e. DPX Log 10 bits), avec une représentation des données qui respecte l’approche historique de la filière argentique. On parle alors de « rendu film ».

Cependant, on aspire à l’utilisation de pipelines linéaires, notamment grâce à des logiciels comme Nuke (permettant de travailler en 32 bits float linéaire). Cette aspiration est de fait renforcée par la disparition progressive de la filière photochimique.

La vérification des images sur divers afficheurs est aussi une réalité : au labo (moniteur de référence rec709), sur le plateau (moniteur de tournage, ordinateur, tablette), au montage (moniteur grand public), à la production (support souvent versatile donc… indéfini). Il est crucial d’être cohérent tout au long de ces différentes étapes, incluant des supports d’affichage très variés.

La présence dans la chaîne graphique d’un moniteur/projecteur de référence calibré, gage de la cohérence des images par rapport à l’espace de couleur cible (Rec709, DCI-P3…), est une condition sine qua none d’une gestion de la couleur sans heurt.

La couleur est un domaine où il faut être en vigilance permanente pour détecter les soucis potentiels de cohérence de ces réglages, en bonne connaissance de cause.

Il est donc nécessaire d’informer régulièrement les utilisateurs et de faire preuve de pédagogie auprès des artistes, mais aussi auprès des différents acteurs décisionnaires : pourquoi calibrer tel écran ? Comment choisir un bon profil sur telle station de travail ou de validation ?

Pour donner quelques exemples concrets, Mikros Image a proposé des réponses à ces questions en mettant en place la Notice pour de meilleures couleurs [1].

Néanmoins, la gestion de la couleur dans une société de post-production reste encore une affaire de spécialistes. La notion de conversion colorée est complexe. Il arrive de recevoir des LUTs dont on ne sait rien (intitulé ou format obscur…). Il faut alors une certaine culture, une certaine habitude d’interprétation des courbes et des

gamuts, une certaine expérience des outils pour convertir les formats et visualiser les données, pour savoir comment les utiliser.

Beaucoup d’utilisateurs finaux, par exemple, ne savent pas faire la différence entre une LUT1D – la transformation porte sur une seule valeur, souvent il s’agit d’une simple modification du gamma et/ou des points neutres – et une LUT3D – la transformation porte sur un triplet, utile pour les transformations colorées plus complexes comme un changement de primaires ou un gamut mapping – (par extension une LUT2D est constituée de trois LUTs 1D, une par canal RGB).

Les artistes ne savent pas toujours – et n’ont pas forcément à connaître dans le détail – quelles transformations il est nécessaire d’appliquer à leurs images.

D’où l’intérêt d’avoir une gestion globale de la couleur dans l’ensemble de la chaîne de fabrication. C’est précisément ce qu’adressent l’ACES et OpenColorIO.

Vers une solution globale de gestion de la couleur

Jusqu’à présent, une brique fondamentale manquait : un espace colorimétrique de référence qui permette d’une part l’échange de fichiers sans prendre le risque de perdre en qualité (notamment au travers des multiples conversions nécessaires au travail en post-production) et la préservation de la scène capturée jusqu’à la génération du DI ; d’autre part de garantir la reproductibilité de l’intention artistique d’une manière plus simple et plus efficace.

L’ACES est cette brique et bien plus.

Présentation de l’ACES

Consciente des difficultés de la gestion de la couleur dans la post-production, l’Academy of Motion Picture Arts and Sciences (AMPAS) a développé une nouvelle architecture englobant la captation, la fabrication et la diffusion. Le but de ces travaux est de proposer un cadre architectural de gestion de la couleur clairement défini, optimal pour la production d’images animées, compatible avec les chaînes de production argentiques et numériques existantes. C’est ainsi que la version 1.0 de la spécification de l’ACES (Academic Color Encoding Specification) a vu le jour en 2008 – à l’époque sous l’appellation IIF (Image Interchange Framework) mais depuis rebaptisé en ACES. Son intérêt est multiple, citons par exemple l’établissement d’un espace de travail colorimétrique de référence (ACES RGB) ainsi qu’un ensemble de transformations colorimétriques de rendu. Le résultat est un concept de gestion de la couleur conçu par les experts du cinéma, basé sur un flux de production pour l’industrie des images animées dans son ensemble. Sans oublier l’un des enjeux affiché par l’AMPAS : fournir des outils permettant de gérer de manière pérenne le patrimoine des films accumulés, avec l’espoir légitime de ré-exploiter ces oeuvres de manière fidèle dans les années à venir, quels que soient les supports et les périphériques de diffusion qui seront alors utilisés.

« Display referred » vs « scene referred »

Avec l’ACES, un changement de modèle s’opère au niveau de la manipulation des images : d’un pipeline dit « display referred », on passe à un pipeline « scene referred » :

Dans un pipeline « display referred » les images que l’on manipule ont été transformées à la source afin d’être adaptées à un périphérique de sortie spécifique (virtuel ou non). Elles perdent leur lien avec la représentation de la scène initialement filmée.

Elles sont, par exemple, encodées en Rec709. Ainsi, tout ce qui dépasse le cadre du Rec709 est compressé voire perdu, rendant l’opération totalement irréversible.

Dans un pipeline « scene referred », l’image que l’on manipule – qu’elle soit issue d’une caméra ou d’une scène 3D – n’est pas visible directement car elle a gardé une relation linéaire par rapport à la radiométrie de la scène. Pour la regarder, il faut passer par une transformation qui s’opère uniquement au niveau du display (cette transformation n’est jamais écrite pendant le processus de fabrication).

C’est grâce à cela qu’il est possible de préserver tout ce qui a été capturé, sans figer le rendu.

L’étalonnage s’opère toujours sur un afficheur de référence (moniteur ou projecteur), en mode « display referred » donc. En revanche, la conformation et les réglages de rendu se font sur les données ACES « scene referred ». La génération du livrable source master peut aussi se faire en ACES pour créer les masters de distribution. Ainsi, le contenu source n’est pas contraint dans un rendu Rec709, il peut garder plus de valeurs que celles qu’il est nécessaire de produire pour une masterisation destinée à un circuit de distribution ou de diffusion donné ou qui évoluera dans le temps (par exemple, le format UltraHD (UHDTV) qui possède un gamut plus étendu).

En quoi ce framework change les choses

Dans la plupart des productions actuelles, un gamut limité et des LUTs associées (sRGB ou P3 par ex.) sont utilisés. La majeure partie des conversions colorimétriques est faite au moment de l’acquisition des images, puis par l’étalonneur au moment de leur traitement correctif. C’est une solution pratique mais étalonner dans un espace borné réduit le spectre des actions à un champ bien limité (les données « superflues » étant perdues), nivelant malgré tout le travail de l’artiste vers le bas.

Grâce à l’ACES, on dispose d’un conteneur unique qui est indépendant des caractéristiques apportées par chaque constructeur à leurs matériels. Cela permet aussi à l’artiste de se concentrer sur l’étalonnage artistique sans avoir forcément besoin de savoir d’où viennent les images.

L’artiste n’a plus à faire la correspondance entre la caméra et le gamut de référence (activité non artistique qui avec les IDTs deviendra automatique et « sans erreurs »), opération qui peut être complexe en fonction des traitements spécifiques utilisés par la caméra.

Au niveau des artistes en général, l’ACES change la donne de manière transparente.

Ceux-ci n’auront pas besoin de connaître la complexité qui se cache derrière la RRT, les IDTs et les ODTs. Ils auront juste à connaître l’espace de sortie qui correspond à leur travail (c’est-à-dire dans quel espace ils veulent voir leur image : sRGB, REC709, DCI…).

Du côté de la capture

Idéalement, les fabricants vont produire les IDTs permettant de passer de l’espace de la caméra vers l’espace ACES en procédant à la caractérisation de leurs matériels (caméras, objectifs…). Pour un modèle de caméra donné, plusieurs IDTs peuvent être produites et notamment une par réglage de température de couleur et de sensibilité.

Plusieurs industriels de référence que sont Arri, Sony et Red sont d’ores et déjà impliqués dans la création d’IDTs pour leurs caméras numériques. Actuellement, la génération de ces IDTs passe par des logiciels propriétaires freeware (Red-CineX chez Red, ArriRawConvertor chez Arri) qui lisent les métadonnées des images pour les interpréter et les convertir en ACES. Il est important de souligner que sans ces métadonnées, on ne pourrait pas gérer les images correctement. À terme, il est probable que cette transformation soit faite au niveau de la caméra et que l’on puisse directement récupérer des images ACES depuis le matériel sans passer par un logiciel tiers-partie.

Du côté du display

Comme pour les IDTs, les ODTs doivent être la responsabilité des fabricants d’écrans et moniteurs de référence.

Pour les moniteurs de référence, on compte Dolby avec son écran PRM4200 qui dispose depuis quelque temps déjà d’un mode Rec709 et d’un mode extended dynamique range. Ce dernier mode préfigure ce dont seront capables les téléviseurs de demain. Au NAB 2012, Dolby a annoncé une intégration des transformations ACES dans l’écran lui-même en tant que toute première implémentation ACES sur le marché. Les RRT et ODT spécifiques ont également été intégrées sous la forme de LUTs. L’implémentation réalisée par Dolby est décrite de manière détaillée dans le document « Direct Display of Integer ACES Content for PostProduction Environments » [2].

Comment évoluer et s’adapter à ces nouveautés ?

S’il est certain que cette révolution est en train d’avoir lieu, le changement ne peut être que lent et progressif notamment parce qu’il induit des préjugés à dépasser.

Par exemple, à l’heure actuelle, même s’il n’y a presque plus de production en film argentique, le recours au format Log reste très présent. Pourquoi ? Parce qu’on aime les images Log, on a l’habitude de les voir et on sait comment les maîtriser.

Adopter l’ACES, c’est bouleverser ces habitudes, notamment en apprenant à regarder les images différemment.

OpenColorIO, vecteur de l’ACES

L’importance de disposer d’un ColorPipe afin de déléguer la complexité de la gestion de la couleur amenée par le numérique n’est plus à démontrer.

Néanmoins, il faut souligner que cette gestion de la couleur et l’adoption de l’ACES doivent être totalement transparentes pour l’artiste, l’utilisateur final.

L’artiste n’a en effet pas à savoir quelles LUTs ou quelles transformations doivent être utilisées. Tout ce qu’il doit connaître est : quelles sont les images qu’il faudra gérer à la fois en entrée et en sortie du processus dont il a la charge. C’est ce qui compte, le reste est de l’ordre de la technique, dont il doit être abstrait le plus possible.

Le framework OpenColoIO (OCIO) [4] propose de gérer cette couche d’abstraction en donnant les outils et méthodes pour traiter les transformations et l’affichage des images de manière cohérente à travers de multiples applications graphiques (compositing, outils de playback, renderers, étalonnage…) utilisées par la postproduction.

Au coeur de cette architecture : la définition d’un fichier de configuration qui permet de décrire les entrées-sorties et d’y associer les transformations (LUTs, LUT3D, matrices 3×3). Ce fichier est écrit/décliné par les experts en gestion de la couleur.

Aujourd’hui une importante communauté s’intéresse au sujet et fait avancer le projet dans les questions adressées et les solutions proposées. La demande des utilisateurs est forte.

OpenColorIO est à l’heure actuelle intégré dans les logiciels majeurs du marché : Nuke et Mari (The Foundry), RV (Tweak Software), ScratchLab (Assimilate)… Un plugin Adobe After Effects est également en discussion sur la liste de diffusion du projet.

Les derniers NAB ont été l’occasion de confirmer cet engouement. Un exemple notable est le pipeline développé par Canon, ColorFront et Aja avec respectivement la caméra C500, le logiciel OnSetDailies et l’ACES.

Récemment, un fichier de configuration ACES utilisant des interpolations tetrahedrales (aces/config_1_0_3.ocio, téléchargeable sur le site d’OpenColorIO) a été mis à disposition. Il est le résultat d’une discussion sur la meilleure façon d’appliquer les différentes pierres angulaires des transformations proposées par l’ACES que sont les IDTs, RRT et ODTs.

Cette nouvelle configuration permet d’utiliser les transformations ACES de manière très précise : on est quasi transparent par rapport à l’utilisation des fichiers CTL originaux.

On sait aujourd’hui qu’une LUT est une approximation trop importante pour qu’elle puisse représenter la transformation RRT+ODT. La meilleure solution est d’utiliser une matrice 3×3, plus une courbe de gradation.

OpenColorIO permet d’appliquer facilement ce genre de transformation.

Il est donc actuellement possible de tester un Color Pipeline intégrant les concepts d’ACES en utilisant les outils proposés par OpenColorIO.

Conclusion

La profusion de formats d’image et de leurs caractéristiques techniques associées conduit à des opportunités importantes de différentiation pour les nouveaux périphériques de capture et d’affichage. Cette opportunité ne doit pas seulement alimenter une compétition entre fabricants d’équipements. Elle peut aussi représenter un défi stimulant pour toute la filière, car la véritable expérience est celle qui associe intimement contenus et équipements. L’expérience vue d’un seul angle ne peut pas être complète, elle est une promesse qui doit être dépassée pour véritablement être tenue. Ce défi concerne donc aussi la filière de distribution, véhicule de l’expérience esthétique des spectateurs que nous sommes tous.

La colorimétrie est une science complexe qui ne doit pas être vue de manière complètement indépendante de la physique, de la physiologie, de la psychologie et de la culture. Cette caractéristique lui confère quelque chose d’unique : une alchimie unique entre technologie, perception, émotion collective et individuelle. La ré-appropriation des outils et méthodes de gestion de la couleur par les chefs opérateurs, les étalonneurs et les artistes devient nécessaire. De plus, la complexité évoquée rend nécessaire la structuration et la dissémination des savoirs induits. Ce faisant, il redevient possible de se focaliser sur la création artistique et non sur la gestion de cette complexité.

Cette reconquête est rendue possible par la simplification des procédés de fabrication grâce à la démarche globale et systématique que proposent l’ACES et OpenColorIO, en réunissant enfin les outils traditionnels de captation, de postproduction et de diffusion avec leurs nouvelles déclinaisons numériques, majoritairement utilisées de nos jours.

Le maintien de l’intention créative jusqu’à son rendu à travers les différents outils de création et de diffusion explique l’engouement déjà suscité par le framework ACES, celui-ci permettant de dépasser les habituelles querelles de chapelles purement techniques (film vs digital, 24p vs 48p, 2K vs 4K, Rec709 vs P3).

On retrouve dans ces préoccupations l’esprit initial qui a motivé le groupe de travail « Cohérence de la perception visuelle » du projet HD3D2 et qui se poursuit au sein du groupe de réflexion « ColorPipe » [3], une communauté d’acteurs académiques et industriels de la postproduction, réunis autour des problématiques de la gestion de la couleur dans le marché de l’industrie des médias et du divertissement.

L’exemple des projets collaboratifs (notamment open source) qui ont fleuri ces dernières années illustre les bénéfices apportés par le partage des réflexions, des savoirs et des méthodes de travail. Ces projets arrivent à mobiliser des communautés d’experts, dont l’intérêt commun est de faire avancer les choses et de partager leurs

résultats avec une communauté plus large.

Les contributions amenées par l’ACES, OpenColorIO et plus généralement autour de ces nouveaux outils et processus permettent de mieux maîtriser la qualité des images, notamment au niveau de la couleur, qui en reste l’un des composants fondamentaux.

Références

[1] Notice pour de meilleures couleurs : http://www.mikrosimage.eu/realisations/colorimetrie-notice-pour-de-meilleures-couleurs/

[2] “Direct Display of Integer ACES Content for PostProduction Environments” : http://www.dolby.com/uploadedFiles/Assets/US/Doc/Professional/SMPTE_ACES_white%20paper.pdf

[3] ColorPipe : http://www.colorpipe.org/

[4] OpenColorIO : http://opencolorio.org/

Ludovic Noblet / Dolby

Diplômé ingénieur en électronique et traitement du signal de l’Ecole Polytechnique de l’Université de Nantes, Ludovic a acquis une expérience de 20 années dans le développement et le déploiement de technologies, systèmes et services audiovisuels numériques pour le compte de Technicolor, Orange et aujourd’hui Dolby Laboratories. Expert en formats, frameworks de production/post-production, compression et distribution vidéo, il représente Dolby dans plusieurs organismes de standardisation et consortia sur des sujets comme la 3D, HEVC, 4K, UltraHD. Après avoir été directeur image/video platform management chez Dolby basé à San Francisco, Ludovic est aujourd’hui directeur business development Image/Video pour la région EMEA, basé à Paris.

Benoît Maujean / Mikros Image

Diplômé de l’École Supérieure des Ingénieurs de Marseille et de l’École Nationale Supérieure des Télécommunications, Benoît débute chez Mikros Image en 1987 comme monteur truquiste et ingénieur de la vision, puis poursuit son parcours en créant le département Computer Graphics de Mikros Image. A partir de 1999, il devient superviseur R&D pour mettre en place différents outils maison pour le développement du cinéma numérique et des effets spéciaux. En 2002, il devient Directeur Technique, à la tête des équipes Support Technique. Il participe activement à des projets collaboratifs, dont les projets FUI HD3D-iio et HD3D2, pour adresser avec 7 autres prestataires les problèmes structurants de la post-production : asset management, colorimétrie, échanges sécurisés, gestionnaire de calculs. Depuis 2007, il est responsable de la Recherche et du Développement. Il assure le management des équipes et des projets de R&D, permettant à Mikros Image de proposer un ensemble de services toujours plus innovants et compétitifs.

Marie Fétiveau / Mikros Image

Diplômée de l’école d’ingénieur IMAC (Image Multimédia Audiovisuel et Communication) et d’un DEA IFA (Informatique Fondamentale et Applications) option Image et Cinéma, Marie évolue depuis 6 ans au sein de Mikros Image – société de post-production – en tant qu’ingénieur de Recherche et Développement spécialisée dans les problématiques de gestion de la couleur et du Cinéma Numérique. Ces dernières années, elle a participé aux réflexions autour de l’ACES et plus généralement de la Cohérence de la Perception Visuelle dans le cadre des projets collaboratifs HD3D-iio et HD3D2. Elle anime également l’équipe de développement de TuttleOFX, un framework open source de conversion de séquences d’images.