« La VR ne doit pas se résumer à la 360 ° », prévient d’emblée Fabrice Lorenceau. Et ce, pour plusieurs raisons : « Il est peu confortable pour l’utilisateur de devoir regarder à 360 °. D’ailleurs, les analytiques montrent que celui-ci passe 99 % de son temps sur les 180 ° devant lui. Ensuite, il est rare que l’action puisse se dérouler réellement à 360 ° autour de la caméra. Enfin, la 360 ° ajoute des contraintes techniques et de bande passante à prendre en compte », égrène le directeur de production et co-fondateur de LiveLike. Tout en reconnaissant que la vidéo 360 ° a aussi des atouts avec une diffusion aisée sur les réseaux sociaux et dans toute application ou page web pourvue d’un lecteur vidéo 360 °.

Amenant une approche dans le sport qui mélange 180 °, 360 °, réalité augmentée, avatars et environnements 3D, flux de data et flux télé traditionnel, la société a produit soixante-seize événements en 2017. Cette année, elle interviendra sur des tournois d’e-sport, Roland-Garros et, surtout, la Coupe du monde de football en Russie, après avoir eu l’occasion de s’échauffer, entre autres, sur la Ligue des champions de football et le Super Bowl (football américain) au cours de ces trois dernières années. Pour justifier ce choix, « l’analyse des différentes offres techniques nous a permis de comparer plus d’une dizaine d’entreprises du marché digital », confie-t-on chez Host Broadcast Services (HBS), l’opérateur hôte de la Coupe du monde de la Fifa dirigé par Francis Tellier.

Un écosystème déjà bien rodé

La première opération pilote réalisée par LiveLike remonte ainsi à décembre 2014, à l’occasion du match du Top 14 de rugby Stade Français – Toulon ; celle en live, au match de Ligue 1 Paris SG – Guingamp, en partenariat avec Canal +, en septembre 2015 ; enfin, celle en live et grand public, au mois d’avril 2016, à l’occasion du « Clasico » Barcelone – Real Madrid, en partenariat avec MediaPro et Samsung.

Pour ce type d’opération, l’écosystème de production mis en place comprend généralement de trois à huit caméras dédiées à la VR (180 ° et/ou 360 °). LiveLike intègre aussi à sa production le flux télé, qui sert à générer un écran virtuel pour les ralentis, les gros plans, etc., ainsi qu’un lounge, des interfaces de statistiques, des avatars… qui viennent se superposer à la captation immersive. Les images sont délivrées à l’utilisateur, via une application mobile (iOS, Android, GearVR…), sous forme de réalité mélangée entre les images VR et un salon VIP interactif. Surtout, « ce que nous n’espérions pas vraiment s’est produit récemment, à savoir que nos flux VR sont maintenant utilisés dans la production broadcast », savoure Fabrice Lorenceau. Côté audio (lire encadré), « dans une expérience sportive, le son doit être plus grand que nature. C’est pour cela que nous spatialisons le mix audio de la télé pour la VR, plutôt que de nous contenter du son immersif du point de vue de la caméra », précise le responsable.

Selon les clients, la protection des contenus s’effectue par un token sécurisé, DRM (Digital Rights Management), geoblocking, aussi bien de l’application que des flux, et authentification. Ainsi, sur Fox Sports, l’utilisateur doit s’identifier pour accéder au live. Pour la prochaine Coupe du monde également, les règles de sécurité de la Fifa pour les contenus immersifs seront celles qui s’appliquent déjà aux contenus multimédia, se traduisant dans les faits par un cryptage avec clé d’authentification.

Pour la brique de production dédiée à la captation, les technologies utilisées sont généralement, en ordre principal et occasionnel, Ateme Titan et Elemental pour l’encodage ; Keepixo, Ateme, Elemental et Wowza pour le packaging ; Avid HDVG4 avec 4D-Play et Flowgic pour le graphisme en réalité augmentée ; BMD Atem Broadcast pour le contrôle caméra et l’étalonnage en live ; AfterEffect + Mettle pour la postproduction ; Vahana de VideoStitch (en live) et MistikaVR (en postproduction) pour le stitching (assemblage d’images). Lequel reste une opération lourde nécessitant beaucoup de ressources. Pour le Mondial, cependant, la production VR s’en échappera au profit d’un flux live 180 ° créé depuis la tribune principale et qui alimentera les studios virtuels des ayants droit.

Quant aux contenus VOD, « nous sommes en cours de définition sur la meilleure offre technique caméra/logiciel de stitching. Nos tests en conditions réelles lors de la Coupe des Confédérations en juin dernier en Russie (NDLR : une compétition dans le pays d’accueil qui sert traditionnellement de répétition générale au Mondial) nous orientent vers une solution à deux lentilles », indique-t-on chez HBS.

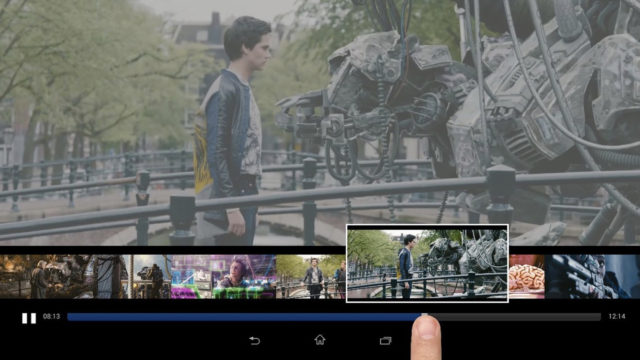

Pour le montage, « nous utilisons des XT4 d’EVS, comme lors du dernier Super Bowl, et, récemment, faute de solutions satisfaisantes sur le marché, nous avons lancé en interne le développement d’un outil de LiveCut dans le cloud », indique Fabrice Lorenceau. « À terme, celui-ci doit nous permettre de répondre à plusieurs challenges techniques, entre autres couper et gérer des flux multi-angles, assembler et exporter plusieurs des playlists de clips en multi-angles, gérer le HEVC et H264 en quasi temps réel et proposer la solution en local et dans le cloud pour plus de sécurité et de flexibilité. » Selon les cas ou les besoins de l’opérateur, l’analytique dans le cloud s’appuie sur Google Analytics, Facebook Analytics, Amplitude et AWS Periscope.

Au final, LiveLike a su démultiplier l’implication et la durée de visionnage des utilisateurs, grâce à des avatars leur permettant de discuter entre eux tout en regardant un événement, et élargir le public cible en proposant une expérience immersive disponible avec ou sans casque, grâce à l’option tactile (Magic Window).

Coupure sociale

En 2015 et 2016, beaucoup utilisaient des Google Cardboards. Oculus et Samsung étaient alors les seuls à proposer un casque, intégrant des capteurs, conçu intrinsèquement pour la VR afin de minimiser la latence entre le mouvement et le photon. « Avec Daydream, Google labélise les téléphones intégrant par défaut de tels capteurs et un matériel à la hauteur pour aboutir à une expérience VR de qualité », souligne Fabrice Lorenceau.

Peu à peu, la contrainte du casque va disparaître. « Le développement de plus en plus important d’Apple dans l’AR démontre que le marché du contenu immersif est en pleine ébullition, tendant à plus ou moins long terme à l’émergence de nouveaux équipements et moyens de consommer », avance -t-on chez HBS.

Pour l’heure, l’autonomie des batteries reste faible et certains casques VR sont liés à leur base par un câble limitant les déplacements. Néanmoins, « pour l’interactivité, les derniers modèles intégrant des capteurs permettent d’utiliser son corps comme dans la réalité pour se déplacer ou interagir. C’est un gros avantage : on implique plus facilement les utilisateurs et il n’y a pas de temps d’apprentissage », abonde de son côté Fabien Barati, directeur général d’Emissive, créateur d’installations VR et AR (hors 360 °) mettant en scène un sport (saut d’obstacles, tennis…), un produit ou une marque, environnements dans lesquels les utilisateurs vont interagir, comme Holotennis pour le compte d’Orange lors du dernier tournoi de Roland-Garros.

D’un point de vue social, la mise en place d’interactions dans l’environnement applicatif permet de rompre l’isolement des utilisateurs. « Il y a une expérience socialisante du sport qui est aujourd’hui perdue quand on met un casque de réalité virtuelle sur la tête. L’aspect immersif ne compense pas la perte de sociabilité », déplore ainsi Charles Lesoil, responsable ingénierie et projets au sein de la Direction Technique Edition (DTE) du groupe Canal +.

Comparé à la 3D, à laquelle certains gourous de l’audiovisuel prédisent le même sort, « la VR demande un changement de comportement similaire, mais propose une expérience beaucoup plus disruptive », réagit Fabrice Lorenceau. « Les géants de l’Internet (NDLR : qui font beaucoup d’annonces, les uns sur la VR, comme Facebook, les autres sur l’AR, plus que sur la VR360, comme Google et Apple) l’ont bien compris. Ils sont habitués à mener cette bataille du changement et déterminés à réussir ce pari d’un écran encore plus intime et impactant que le téléphone mobile. »

Ainsi, Oculus Venues, la nouvelle application VR d’Oculus, filiale de Facebook, dont le déploiement est prévu pour 2018, permettra au plus grand nombre d’utilisateurs dans le monde de partager en direct des événements sportifs et autres.

Un nouveau storytelling

Pour la Coupe du monde, deux types de services ont été proposés pour une expérience unique : une application en marque blanche pour la réalité virtuelle, s’appuyant sur des solutions fournies par LiveLike, mais par aussi l’italien Deltatre, partenaire technologique historique de la Fifa ; et un contenu immersif 360 °, lequel a été produit en synergie avec les équipes ENG déployées par HBS durant la compétition.

La première a permis à n’importe quel utilisateur dans le monde de se transporter dans la loge VIP du stade, de visualiser le direct (flux 180 °), mais aussi de venir s’asseoir derrière les buts. L’application, universelle en termes de supports de visualisation, tournait aussi bien sur iOS et Android que sur d’autres plates-formes telles que Sony VR, Oculus Rift et Gear VR. « D’un point de vue éditorial, il était important de donner la possibilité aux ayants droit d’analyser l’impact des différents contenus sur les utilisateurs. La solution standard proposée leur permet donc de connaître quelle section vidéo ou donnée a été la plus consultée. Par ailleurs, le Media Asset Management proposé leur permet de mettre à jour le contenu de l’application en temps réel et de modifier l’expérience utilisateur instantanément », précise-t-on chez HBS.

Quant au contenu immersif 360 °, produit par 52 caméras, il permettait de s’immerger littéralement dans l’ambiance des matches, mais aussi d’accéder aux coulisses du tournoi », indique la même source.

Que ce soit à 180° ou 360°, une caméra VR est immersive, mais ne propose pas de longue focale, d’où l’importance de son placement. L’absence de focale a conduit la Fifa à proposer, via son application VR, deux écrans géants virtuels. Positionnés dans les virages du stade, ces derniers ne faisaitplus qu’un au centre du terrain à chacune des actions clés du match. L’utilisateur pouvait ainsi revoir l’action plus clairement.

D’autre part, dès lors que trois caméras VR (une dans la tribune principale et une derrière chaque but) étaient déployées sur chacun des douze stades de la compétition, comment switcher de l’une à l’autre, sauf à recourir à un réalisateur dédié ? HBS a fait le choix de confier les clés de la réalisation à l’utilisateur final, lequel pouvait à n’importe quel moment du match choisir sa position dans le stade, en tribune principale ou derrière un but.

En septembre dernier, LiveLike a même testé un flux 180 ° depuis une caméra aérienne (Skycam) opérée par Fox Sports lors d’un match universitaire de football américain mais l’option n’a pas été mise en place pour le Mondial russe. Si, avec la 360 °, la notion d’angle mort disparaît, encore faut-il utiliser la technologie à des moments bien choisis (présence des équipes dans le tunnel d’accès au terrain, protocole d’avant-match…), que ce soit sous forme d’ENG ou de live. À quoi bon, en effet, streamer en permanence un flux 4K 360 ° si, à l’instant T, l’utilisateur s’hypnotise sur la scène à 180 ° devant lui ? « Les premiers retours que nous avons sur ce nouveau storytelling est qu’il faut imaginer la vidéo 360 ° comme une pièce de théâtre », explique de son côté Alain Nochimowski, EVP Innovation chez Viaccess-Orca, avant de développer : « L’utilisateur est plongé dans un environnement à 360 °, ce qui lui confère cette sensation d’immersion ou de présence tant recherchée. Le fait de ne proposer qu’une partie (110 °, 180 °) rompt très rapidement le sentiment d’immersion. Pour autant, l’action doit être concentrée devant l’utilisateur pour son confort. »

La retransmission du football ne déroge pas à cette analyse… Ainsi, pour la Coupe du monde, « nous n’avons pas utilisé de caméras 360 ° pour le live immersif », annonce HBS. « En effet, les dimensions du terrain et la captation propre à ce type de caméra ne permettaient pas de voir le ballon. » Pour chacun des 64 matches du tournoi, trois flux live 180 ° issus de caméras broadcast Sony F55 4K munies chacune d’une lentille hémisphérique (Fish Eye) étaient mises à disposition via l’application VR de la Fifa ou directement par l’API de HBS. D’où il apparait au-delà de l’exemple du Mondial, qu’avec une loge virtuelle, on peut diminuer l’encodage, dont la qualité n’est pas toujours au rendez-vous, et concentrer l’action sur ce qui est important.

Pour réduire les besoins en bande passante, des solutions existent, comme le HEVC, qui permet une compression plus efficace – jusqu’à 30 % – sur le contenu haute résolution. De leur côté, les technologies CMAF réduiront la quantité de bande passante nécessaire pour un streaming à très haute définition.

Dans ce domaine, depuis les premières opérations pilotes, comme le match France-Russie, diffusé en 4K par TF1 en mars 2016, qui utilisaient les standards de streaming adaptatif (Dash…), beaucoup de progrès ont été réalisés afin d’améliorer la qualité de l’image et les techniques de diffusion, grâce notamment au « tiling ». « Cette technologie consiste à découper la représentation sphérique de la vidéo 360 ° en tuiles (“tiles”) afin d’optimiser la résolution d’image pour les tuiles présentes dans le champ de vision de l’utilisateur, tout en se contentant d’une résolution moindre pour le reste de la sphère », rappelle Alain Nochimowski, avant de conclure : « Cela permet de réduire significativement la bande passante nécessaire au streaming vidéo, tout en améliorant la QoE (Quality of Experience). » La filiale d’Orange s’est d’ailleurs associée à l’un des leaders du secteur, TiledMedia, dont elle intègre la technologie, faisant ainsi du player Viaccess-Orca l’un des lecteurs vidéo VR360 les plus avancés du marché.

Quelles alternatives ?

Aujourd’hui, outre la caméra 360, l’autre technologie en VR est celle du free viewpoint. Parmi les acteurs de la vidéo volumétrique et des light fields, Intel a ainsi développé un système qui permet d’aller encore plus loin que la première. « Cela signifie que l’utilisateur peut se placer où il veut pour regarder un match », résume Fabien Barati. Mais le système est lourd à déployer, mettant en jeu de puissants serveurs en aval pour l’agrégation des vidéos 360 en temps réel, et l’utilisateur final aurait envie d’une immersion interactive en direct.

De plus, si la solution est intéressante, « elle est trop onéreuse », ajoute-t-on chez HBS. « Notre veille technologique nous avait orientés vers FreeD avant son rachat par Intel, mais les ressources techniques nécessaires à son implémentation ne nous permettaient pas de déployer cette technologie pour l’échéance du Mondial. D’autre part, le rendu final reste plus proche d’un jeu vidéo que d’une production broadcast. »

D’ailleurs, certains acteurs du sport, Canal + en tête, lequel a pourtant été le premier en France à réaliser un test grandeur nature de loge virtuelle à l’occasion d’un match du Paris SG et à mettre à disposition sur son application myCanal une collection de vidéos 360 ° orientées sport (formule 1, boxe, rugby, football…), compatibles avec les casques du marché (Cardboard et autres), semblent désormais plutôt miser sur les valeurs immersives de l’Ultra HD, le déploiement du HDR (High Dynamic Range), qui permet un meilleur rendu des couleurs et de la lumière, et, côté audio, celui de la technologie Dolby Atmos pour changer le storytelling du sport.

L’audio en reconquête ?

Longtemps considérée comme le parent pauvre du sport broadcast traditionnel, la composante audio va-t-elle rebondir avec la VR ?

Ici, l’intégration du son spatial représente une forte valeur ajoutée et ne nécessite que des techniques aussi simples que l’encodage binaural. « Pour la première fois, nous sommes en mesure d’utiliser la technologie existante à sa capacité réelle », se réjouit-on chez HBS, l’opérateur hôte de la Coupe du monde de la Fifa. De même, le « Head Tracking » apporte un vrai plus à l’expérience immersive. Plus précisément, les casques VR, y compris les téléphones utilisés comme tels, disposent de trackers permettant aujourd’hui de prendre en compte l’orientation de la tête et, donc, d’adapter les traitements audio.

« Quand on parle de transmission d’évènements live, on a tendance à se limiter aux éléments sonores réels, mais une partie de l’expérience peut venir d’autres éléments, comme, par exemple, matérialiser le présentateur, partager l’expérience avec un ami distant dont la voix est spatialisée sur son avatar, partager une interview, profiter de plusieurs caméras… Nous considérons donc le son comme une modalité d’interaction qui peut répondre à des problématiques au-delà du champ sonore en lui-même », analyse Marc Muller, co-fondateur et directeur général d’AspicTech.

La société basée à Tourcoing développe ainsi une solution matérielle et logicielle, encore en phase de test, qui devrait être déployée courant 2018 et qui cible, entre autres événements live en VR, l’univers du sport. Baptisée Aspic Cinematic VR Live Edition, son but est de permettre d’envoyer un flux audio 360 vers l’utilisateur distant afin qu’il profite d’une expérience encore plus immersive. Cela passe non plus par un unique microphone ambisonique placé au niveau de la caméra 360, mais par une acquisition des différentes sources audio directement en sortie de console : flux mono à spatialiser, provenant de sources ponctuelles ou isolées ; micros ambisoniques permettant une captation 360 °, particulièrement utiles pour les prises d’ambiance ; et sources extradiégétiques (commentateurs…), en stéréo, qui peuvent rester fixes dans le champ sonore. « La solution permet de positionner les sources sonores et de traquer leurs déplacements afin de piloter des encodeurs temps réel qui produisent le flux audio final spatialisé, prêt à être transmis », complète Marc Muller. Outre l’utilisation des flux audio en sortie de console, son intérêt réside dans sa rapidité de déploiement (quinze minutes au maximum) et la possibilité d’ajout d’encodeurs sur mesure au format de chaque réseau de diffusion.

* Article paru pour la première fois dans Mediakwest #26, p. 86-89. Abonnez-vous à Mediakwest (5 numéros/an + 1 Hors-Série « Guide du tournage ») pour accéder, dès leur sortie, à nos articles dans leur intégralité.