Le studio mocap de qualité demeure une affaire de spécialistes. Il faut investir dans plusieurs dizaines de caméras (Vicon, OptiTrack, MotionAnalysis…), savoir s’en servir (calibrage, pose des marqueurs, etc.) et maîtriser le tournage et une chaîne de postproduction qui démarre en général sur MotionBuilder.

Après l’Angleterre, la France est le pays européen le mieux équipé avec trois sociétés renommées : Quantic Dream, MocapLab et SolidAnim.

L’éditeur de jeux vidéo Quantic Dream n’est plus à présenter. Sa réputation solide dans l’univers très concurrentiel du jeu tient à des personnages réalistes et à de vraies histoires. En 2014, il a investi dans 38 nouvelles caméras Vicon T160, portant leur nombre à 64. Son bébé actuel est Detroit : Become Human, une exclusivité sur PS4 pour laquelle David Cage, le fondateur du studio, promet une animation faciale d’une qualité inégalée.

Pour sa part, SolidAnim est équipé de deux studios, avec un plateau à Angoulême muni de 22 caméras Vicon et, depuis début 2015, avec un nouveau plateau de 200 m², installé à Orly au sein de l’école Georges Méliès, équipé de 26 caméras Vicon. Par ailleurs, le prestataire est équipé de 18 caméras OptiTrack.

Un autre prestataire de services, MocapLab, a été fondé par Remi Brun qui se félicite de « leur déménagement en septembre dernier à Aubervilliers, avec 450 mètres carrés de bureaux et un studio équipé de 30 caméras mocap T160 et de tracking de regard ».

Mais à côté de ces studios profilés pour les VFX ou l’animation de qualité, la motion capture se démocratise. Ainsi, l’éditeur russe iPi Soft a développé une technologie de mocap sans marqueur, qui se satisfait de matériel grand public, comme les Kinect, les caméras PlayStation Eye et les manettes PS Move. Ce produit abordable est apprécié pour des applications pour le jeu, le web ou les appareils mobiles.

Animation, davantage qu’une rotoscopie 3D

Si la mocap au service des effets visuels photoréalistes en fiction est indispensable et rodée, ce marché demeure assez limité en France. La technique est principalement exploitée en animation non photoréaliste, pour le jeu vidéo, les avatars web ou l’animation. Équivalente pour ces détracteurs à de la rotoscopie 3D quant au résultat, l’usage de la mocap en animation suscite régulièrement des polémiques. Jusqu’où l’utiliser et la retravailler ? À quel style visuel l’associer ?

En 2015, deux longs-métrages d’animation français et franco-belge ont tiré parti des possibilités de la technique, avec des budgets et des ambitions très différentes.

SolidAnim a apporté son expertise de la mocap sur le long-métrage belge Cafard (2015), réalisé par Jan Bultheel, coproduit avec la France et les Pays-Bas pour un budget inférieur à 3 millions d’euros. Le tournage s’est déroulé en Belgique en deux temps, body et facial séparés, avec un objectif de productivité et un retour temps réel au tournage, afin que le réalisateur puisse valider très vite la mise en scène. Le traitement des corps et des visages est pictural.

Plus ambitieux, Pourquoi j’ai pas mangé mon père, de Jamel Debbouze et Frédéric Fougea, a bénéficié d’un budget d’une quarantaine de millions d’euros. Un studio de mocap provisoire avait été monté à Stains par Marc Miance avec un plateau de 150 mètres carrés et 70 caméras Vicon. Le tournage a duré 45 jours avec une captation simultanée du corps et du visage grâce au développement par Alkymia d’un nouveau casque ultra-léger Thirdeye avec une caméra miniature embarquée. Sur le tournage, une partie de l’environnement de l’arbre géant, avec lequel les acteurs devaient interagir, a été reproduite. Un cyclo de 35 mètres de long sur 8 mètres de haut, avec un décor de savane, a été élevé par la production tout autour de la scène de captation, afin d’aider les acteurs à se sentir dans l’ambiance.

Pour février 2018, c’est Croc-Blanc qui est attendu sur les écrans. Ce long-métrage d’animation, produit par Superprod, est réalisé par Alexandre Espigares avec de l’animation mocap signée SolidAnim pour les humains et pour les chiens.

Chez MocapLab, le marché principal est aussi celui du non photoréaliste, avec comme exemple la très belle série d’animation Carnets de Voyage (Arte), les spots publicitaires Pens pour Amnesty International ou la récente campagne pour la Maif avec toujours les mêmes personnages bâton stylisés, mais animés en mocap et non par key-frames. Son plus important travail a porté sur le jeu vidéo épisodique Life is Strange, pour lequel MocapLab a tourné sur une semaine environ quatre heures de mono-personnage, pour réaliser environ 90 minutes d’animation.

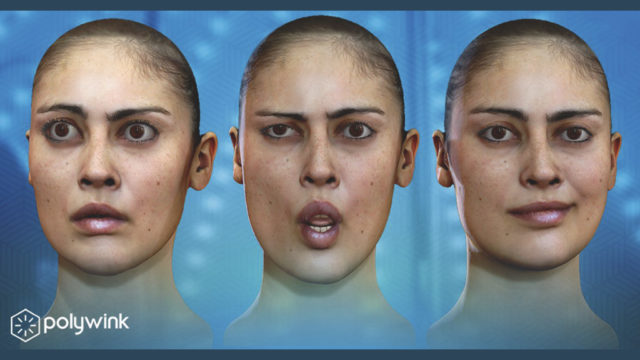

Le défi du facial

En augmentant le nombre de caméras, les prestataires peuvent agrandir les dimensions de leur plateau de tournage et capter les mouvements de plusieurs comédiens en simultané, avec un bon réalisme. Le challenge demeure la saisie des expressions du visage, miroir fluctuant des émotions qui est toujours complexe à capter et à reproduire dans ses subtilités.

Chacun a sa recette. Les captures corporelles et faciales (avec un casque muni d’une caméra légère) peuvent se faire en simultané ou en deux prises séparées. Le visage peut porter de petits marqueurs ou aucun marqueur, avec dans ce cas un tracking dit markerless uniquement par reconnaissance d’images et détection de contours. Des casques sont commercialisés comme Cara de Vicon qui portent quatre caméras HD, Technoprops ou ThirdEye d’Alkymia.

Une fois les expressions captées, il faut les exploiter. SolidAnim s’est concocté un outil maison avec l’aide de Game Audio Factory. Baptisé Gleam Session, ce système permet d’enregistrer en même temps l’expression et le regard d’un acteur, ainsi que l’audio. Digital Domain exploite la technologie Contour de Mova, qui a permis de réaliser de nombreux clones virtuels hyper réalistes, depuis ceux de Brad Pitt pour L’étrange histoire de Benjamin Button (2008), jusqu’au récent héros de Deadpool. La performance complète de l’acteur est filmée avec une grille de caméras, qui saisit 7 000 à 8 000 points, permettant d’obtenir les expressions, mais aussi des textures animées en très haute résolution sous l’éclairage de son choix.

Une autre approche est celle de Faceware Technologies, qui fait de la capture faciale sans capteurs, devenu partenaire de Vicon pour proposer une solution complète body et visage. En début d’année, ce sont les sociétés Technoprops (un fabricant de casques avec caméra embarquée bien installé sur le marché du jeu vidéo) et Dimensional Imaging (éditeur du logiciel DI4D), qui ont annoncé leur partenariat pour proposer un système complet de capture faciale en haute résolution. Enfin, l’éditeur français Dynamixyz commercialise un logiciel innovant de tracking facial sans marqueurs et qui, depuis cette année, fonctionne aussi avec marqueurs.

L’essor des nouveaux marchés

L’innovation en mocap vient aussi de l’exploration de nouveaux marchés et de nouvelles applications. Un bon exemple est donné par SolidAnim avec son outil SolidTrack, qui permet de faire de la previz temps réel sur les tournages de blockbusters à effets visuels grâce à du tracking de caméra.

« Nous avons aussi développé récemment une nouvelle plate-forme temps réel avec du rendering. Il s’agit d’un workflow complet avec tracking caméra, mocap et rendu final dans le moteur 3D Unity. Ce produit sur étagère peut servir par exemple pour le design d’émissions TV, en permettant de concevoir très rapidement une animation, soit avec du tracking de marionnettes, soit avec du mocap d’acteurs réels », confie Isaac Partouche, président de SolidAnim.

Un autre exemple est apporté par la société Eisko (anciennement ADN, l’Agence de Doublures Numériques) qui est spécialisée dans la reproduction fidèle de la performance d’acteurs virtuels. Ses équipes ont développé leur propre système de captures, une cellule de scan photogrammétrique qui enregistre les textures et les matériaux dans leurs différentes composantes, diffus, spéculaire, normales, rugosité… Ces composantes sont ensuite recombinées pour la synthèse du clone virtuel.

« Au départ, notre cellule était en forme de sphère et donnait un volume fixe. Nous avons développé un nouveau système de capture qui permet de reconfigurer le volume de capture. Le champ de capture est défini par la position des nœuds, qui servent à la fois pour illuminer l’acteur et prendre des photos. Il est donc possible de saisir aussi bien un homme sur pied, une interaction entre personnages ou de réduire le volume de manière à saisir une main de manière détaillée », explique Cédric Guiard, directeur d’Eisko.

Si son marché initial demeure toujours la doublure numérique pour le cinéma, Eisko s’est ouverte ces dernières années largement vers des applications industrielles, pour les jeux vidéo ou des applications interactives pour d’autres médias, par exemple pour des modules de réalité virtuelle ou augmentée (par exemple type assistant virtuel sur smartphone) ou pour de l’impression 3D.

* Extrait de notre article paru en intégralité, pour la première fois, dans Mediakwest #17. Abonnez-vous à Mediakwest (5 nos/an + 1 Hors série « Guide du tournage) pour recevoir, dès leur sortie, nos articles dans leur totalité.