La première étape, c’est le stitching. Sur le sujet, l’offre logicielle se raréfie cette année, notamment à cause de l’annonce de la fermeture de Kolor, rachetée par GoPro en 2015, cette société française était spécialisée dans la conception de logiciels de stitching, dont la célèbre suite Autopano Video et Autopano Giga. Le brusque arrêt de son activité laisse le champ libre au poids lourd incontournable du moment : Mistika VR.

Ce logiciel, édité par la compagnie espagnole SGO bien connue des grands studios pour ses outils de traitement stéréoscopique (Mistika Ultima), est aujourd’hui très utilisé par les créateurs d’expériences VR. Sa dernière version 8.8.7 intègre toutes les fonctionnalités nécessaires à un stitching « invisible ».

Combinant qualité avec la technologie optical flow et rapidité avec l’optimisation GPU, le logiciel s’enrichit de fonctions de stabilisations, d’animation de points clés et d’une bibliothèque de profils caméras toujours plus importante. Un de ses points forts : l’équipe de développement travaille en étroite collaboration avec les fabricants Kandao et Insta360 et permet d’importer les métadonnées de calibration directement dans la fenêtre de stitching. Résultat : un « preset » personnalisé unique correspondant parfaitement à votre caméra.

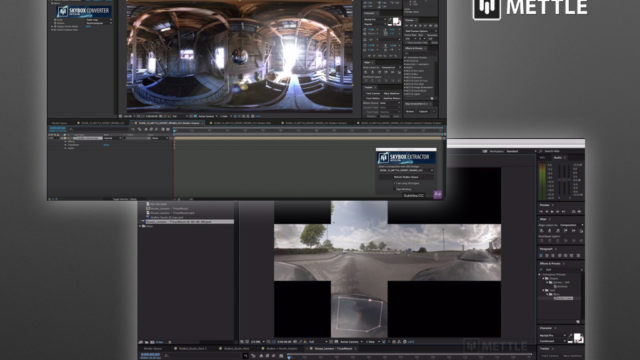

Après le stitching, viennent le montage et les effets spéciaux. L’éditeur le plus avancé dans ces domaines est sans conteste Adobe, très présent dans la 360 et encore plus impliqué depuis le rachat par l’entreprise d’une partie des activités de la société Mettle. Depuis l’an dernier, Adobe intègre dans sa suite CC les outils indispensables à la postproduction d’expériences immersives. Les plus récents offrent la possibilité de manipuler la timeline de Premiere directement dans un casque VR de type Oculus Rift, HTC vive ou Windows MR, en utilisant les contrôleurs. Une immersion dès la fabrication des expériences, qui rend le travail de création beaucoup plus intuitif !

Du côté de la masterisation 360, Adobe Media Encoder nous propose désormais un encodage H264 jusqu’à 8K en natif, assorti d’un son ambisonique : plus de pixels pour plus de réalisme… La dernière itération d’Adobe CC permet également de gérer le format VR180 plébiscité par Google, dont nous parlerons plus loin. On peut bien sûr ajouter de nombreux plug-in « VR » à la suite CC.

Flux et Mantra de Mettle ont retenu notre attention : proposés aux créatifs, ils permettent de manipuler, transformer l’image 360 en appliquant des filtres, du plus simple ajout de texte aux déformations les plus artistiques. Flux va encore plus loin en proposant la génération d’environnements 360 volumétriques. Les aurores boréales et autres images du cosmos en 360 stéréoscopique sont à votre portée !

Rotoscopie, tracking et effacement sont généralement des étapes compliquées pour les truquistes VR. Mais heureusement, BorisFX est là pour vous accompagner dans ces moments difficiles… La nouvelle version 2019 de Mocha Pro est disponible. Le logiciel, disponible en standalone ou en plug-in, fait la part belle aux options dédiées à la 360, auparavant intégrées dans Mocha VR : un tracking « plan » extrêmement performant qui permet la stabilisation, la réorientation, l’effacement d’objets, y compris si la caméra est en mouvement, et une gestion automatisée de la rotoscopie sur des images stéréoscopiques qui va automatiquement appliquer la disparité entre œil droit et œil gauche. La nouveauté, c’est aussi l’accélération GPU qui permet un gain de temps considérable à l’étape d’analyse et de rendu.

La Cinématique VR était bien là sur le stand de Google, avec deux concepts. La VR180 d’abord : un écosystème qui propose une captation stéréoscopique à 180 degrés et une visualisation dans un casque de réalité virtuelle via l’application YouTube. Quelques caméras étaient présentées, notamment la K1Pro de chez Zcam qui permet un enregistrement en 3K par œil sur la demi-sphère. Il faut noter que ce format, plus simple à gérer puisque l’étape de stitching est supprimée et remplacée par un « dewarp » de l’image fisheye, est soutenu par Google et Facebook, notamment en ce qui concerne la captation et la retransmission live. Le 360 semble un peu délaissé sur le stand, malgré la présence toujours imposante de la caméra Halo du constructeur YI, partenaire de Google sur le sujet.

L’autre concept présenté par le géant de l’Internet est une démonstration de captation lightfield, pour laquelle un rig propriétaire, constitué de GoPro assemblées, est utilisé. La démonstration est disponible sur les portails Oculus et HTC ; elle est assez impressionnante de qualité, même si pour l’instant les images proposées sont fixes. Mais il faut avouer que ces technologies lightfield ne sont pas encore prêtes à être exploitées en production en raison de leur complexité.

Sur la partie diffusion 360 live, on peut retenir la solution Imeve. Concurrents directs de la société Voysys, les ingénieurs de cette nouvelle structure, issus pour la plupart de l’équipe Ozo Live, nous proposent un logiciel permettant la récupération des flux des caméras 360 (pour l’instant seules les Zcam S1/S1pro et les caméras Ozo sont compatibles), le stitching (automatique ou manuel pour les experts) en utilisant des algorithmes avancés, la correction colorimétrique, la réduction de bruit spatiale et temporelle, la rotation des images dans la sphère, tout ceci avec une latence minime. Les signaux ainsi produits sont encodés à la volée et envoyés sur la plate-forme de votre choix. Le gros plus étant l’intégration toujours en temps réel dans le flux d’un son spatialisé, récupéré à partir de sources audio live mono ou stéréo.

Après la production des contenus en Cinématique VR, il reste la question cruciale de leur distribution. C’est là qu’intervient la solution Liquid Cinema présentée par ses concepteurs dans la future zone. Une suite logicielle innovante qui permet l’authoring de contenus 360, leur publication via une App proposée en marque blanche et compatible avec tous les casques du marché, et une plate-forme web de gestion des contenus qui permet entre autres la gestion du multilangues et le geo-blocking.

En conclusion, un peu moins de nouveautés présentées, mais des outils arrivés pour la plupart à maturité, qui vont autoriser encore plus de créativité. Les meilleures expériences de cinématique VR sont à venir !

Extrait de notre compte-rendu de l’IBC 2018 paru pour la première fois dans Mediakwest #29, p.36/77. Abonnez-vous à Mediakwest (5 numéros/an + 1 Hors-Série « Guide du tournage ») pour accéder, dès leur sortie, à nos articles dans leur intégralité.