Wildmoka, toujours en prise directe avec les plus grands éditeurs TV de la planète, continue d’améliorer sa solution logicielle de « clipping » (édition rapide de courtes séquences), de sorte qu’aujourd’hui elle gagne de la puissance d’indexation avec l’OCR (Optimized Character Recognition) qui permet de « scroler » dans une timeline avec des indications textuelles liées au speech to text réalisé en live. De même, le son en live peut être clippé séparément de la vidéo, en vue de réaliser un podcast par exemple. Enfin, les Analytics ont été renforcés autour de l’audience sur les réseaux sociaux.

Sur l’IBC 2018, l’éditeur français avait aussi quelques concurrents, parmi lesquels, le britannique Grabbyo qui propose désormais sa solution de clipping hébergée dans le cloud d’Amazon. Orienté vers la distribution sur les réseaux sociaux, Grabbyo n’en est pas moins évolué avec la possibilité de gérer jusqu’à trois layers vidéo différents, de gérer des transitions et la possibilité de faire un peu d’habillage, avec notamment l’intégration en temps réel à l’écran d’un fil de commentaires Facebook.

Pour la deuxième année consécutive, on pouvait voir des applications basées sur l’intelligence artificielle en production, mais finalement assez peu d’évolution notable, si ce ne sont les usages qui s’affinent et se segmentent de plus en plus nettement. L’IA en tant qu’outil pour trier les séquences vidéo et servir d’outil semi-automatique de dérushage tenait le haut du pavé.

La BBC montrait par exemple à sa manière comment, sur la couverture du festival d’art d’Edinburgh qui comprend 50 000 événements différents dans 300 endroits distincts, elle a utilisé l’IA pour faire le tri dans les vidéos à sa disposition. L’IA a alors servi à identifier et regrouper des thèmes abordés dans chacune des composantes de cet événement culturel.

Pour l’ingénieur de la BBC en charge de l’IA, Craig White, les systèmes d’IA en production sont encore à l’état de prototype et sont perfectibles. La question clé, selon lui, est : « est-ce que les algorithmes sont suffisamment performants pour être adoptés massivement par l’industrie ? »

De son côté, Dalet montrait les dernières évolutions de son outil IA Media Cortex qui s’appuie sur les modèles de machine learning développés par Microsoft Azure pour proposer une indexation semi-automatique des rushes et un séquençage suivant des mots clés ou des noms de célébrités. Lors de cet IBC d’autres sociétés comme Ooyala ou Avid intégraient la nouvelle technologie d’IA de Microsoft qui annonçait par ailleurs la généralisation de ce service, baptisé Video Indexer sur Azure.

Video Indexer s’appuie sur trois technologies différentes : un outil de reconnaissance des émotions basé sur l’analyse sémantique et de la tonalité des voix, un modèle d’inférence (corpus de déductions) basé sur les sujets abordés dans un discours. Pour cela, Video Indexer suit d’ailleurs le standard de taxonomie conçu par l’IPTC (International Press Telecommunications Council) qui définit des standards au sein de l’industrie de l’information.

Enfin, Video Indexer s’appuie sur un module de reconnaissance faciale des célébrités, avec une base de données d’un million de visages à ce jour extraits de sources comme IMDB, Wikipedia ou les meilleurs influenceurs de LinkedIn. À noter que Endemol a été l’un des premiers acteurs audiovisuels à utiliser Video Indexer en version beta pour dérusher rapidement et efficacement les quantités astronomiques de vidéos réalisées dans le cadre de l’émission Big Brother.

L’espagnol Tedial de son côté jouait sur la carte de l’automatisation des process de dérushage des rencontres sportives avec son nouveau logiciel SmartLive. Cet outil vient en surcouche d’un système PAM de SAM ou EVS en facilitant le séquencement automatique des vidéos suivant les métadonnées associées à une séquence ou un enrichissement de mots clés générés automatiquement. Le module de clipping de Tedial a l’avantage aussi de s’interfacer directement avec la solution MAM de l’éditeur espagnol, permettant ainsi d’enrichir les highligths ainsi générés d’images d’archives.

Dans le même registre, des solutions complètes intégrant MAM et stockage tout en profitant de la puissance nouvelle de l’intelligence artificielle pour faciliter le dérushage semi-automatique de tous les types de programmes, le spécialiste du stockage NAS performant Elements présentait son intégration soignée de Veritone au sein de son MAM.

Rappelons que Veritone est une société américaine qui a créé le premier OS dédié à l’intelligence artificielle, aiWARE. Veritone a été parmi les premières entreprises à utiliser les outils d’AWS pour pousser des solutions expertes en matière de machine learning. Depuis le printemps 2018, Veritone a mis sur le marché un kit de développement robuste incluant des interfaces pré-définies et des instructions pas à pas pour rendre compréhensible son API (Application Programming Interface).

La start-up britannique GrayMeta était installée sur cet IBC sous l’ombrelle de Google et présentait un nouveau service d’intelligence artificielle qui devrait faire parler de lui dans les prochains mois. En effet, GrayMeta lance GrayMeta AI-Powered Plug-in, une extension d’Adobe Premiere Pro CC visant à aider les créateurs de contenus et les éditeurs de chaînes à dérusher plus rapidement et précisément. GrayMeta AI-Powered Plug-in permet de trouver rapidement des séquences spécifiques au milieu de ses rushes et de placer ses séquences directement dans la timeline d’Adobe.

Les métadonnées générées par la plate-forme AI de GrayMeta permettent de faire le tri entre les personnes, des marques et des logos, des objets et des moments spécifiques au sein d’une séquence.

Dans le même registre, mais encore plus orienté sur la remontée vers les journalistes des archives audiovisuelles d’une chaîne TV, l’outil de recherche sémantique de Perfect Memory se perfectionne. Il montrait sur cet IBC un nouveau visage, plus ergonomique et plus performant encore, tout en permettant aussi un export direct des séquences sélectionnées dans le logiciel d’editing d’Adobe.

Toutefois, la comparaison s’arrête là, car Perfect Memory va plus loin dans la recherche des liens sémantiques entre les séquences vidéos à l’intérieur même d’un reportage. De sorte qu’il est possible d’isoler des séquences émanant d’agences de presse, d’en vérifier les droits en temps réel, afin de réutiliser des séquences même anciennes à sa guise… et tout cela en quelques secondes seulement.

De même, Steny Solitude le fondateur de Perfect Memory insiste sur le fait que la recherche sémantique offre une puissance de tri plus importante au sein d’archives profondes, là où la plupart des dispositifs d’IA et de machine learning étaient très orientés sur le nwes lors de cet IBC 2018.

Cantemo fait partie des solutions de Media Asset Management les plus avancées dans le monde actuellement. Sur cet IBC, la société suédoise mettait en avant à destination des acteurs de l’audiovisuel encore réticents à déposer leurs médias haute résolution sur un cloud public pour des raisons de sécurité, un nouveau dispositif intégré à Iconik qui consiste à placer les basses résolutions de médias et leurs métadonnées attachées dans le cloud, tandis que les médias haute résolution demeurent on-premise, les deux étant bien entendu synchronisés.

Cela permet, entre autres, le partage plus aisé des médias à l’extérieur de l’entreprise via un système de notifications et de bénéficier de toutes les fonctionnalités évoluées d’Iconik comme l’indexation et la recherche intelligente au sein des séquences vidéo.

En outre, la solution Iconik peut être hébergée au choix sur plusieurs clouds différents, parmi lesquels Glacier d’Amazon, mais aussi Google Cloud Storage ou encore au sein des Datacenter de Back Place, un nouveau venu américain qui propose des tarifs pour l’archivage encore plus attractifs que les autres géants du cloud. En outre, Iconik propose d’utiliser, au choix aussi, les deux principaux systèmes de reconnaissance visuelle d’objets et de visages que sont Google Cloud Video Intelligence et Amazon Rekognition.

PLAYERS AUGMENTÉS À L’IA

De son côté, Hexaglobe présentait cette année une version finalisée de son player baptisé X-Treme Player très orientée vers le live sportif. Il s’agit d’un outil de visionnage destiné au web qui permet au téléspectateur d’une manifestation sportive de regarder plusieurs flux en streaming live simultanément et de zapper d’un flux à l’autre.

Le back office de X-Treme Player permet aussi bien de faire du clipping pour le social media que de créer de manière dynamique des points clés sur la timeline du futur téléspectateur, qui pourra ainsi directement aller vers les séquences qui l’intéressent. De même, le nouveau player d’Hexaglobe propose le ralenti à l’image prêt et une avance rapide jusqu’à 8x. À noter qu’Hexaglobe a déjà eu l’occasion de déployer ce player dynamique auprès des abonnés de la chaîne Equidia.

En plus de ces fonctions de base propres au player, Hexaglobe présente aussi un module de reconnaissance faciale utilisant ses propres algorithmes de reconnaissance d’objets, afin de repérer par exemple les casaques des chevaux sur un champ de course. Ainsi, il est possible d’enrichir de métadonnées les séquences vidéo, afin de retrouver plus facilement des compétiteurs au sein d’un live sportif.

Autre initiative d’une chaîne, et qui vise à utiliser le potentiel de l’IA pour augmenter l’expérience du téléspectateur à l’intérieur même de la page web du player vidéo, Sky Digital montrait comment il s’est appuyé en mai 2018 sur les outils de reconnaissance faciale d’Amazon (Amazon Rekognition) et sur le savoir-faire d’une start-up anglaise spécialisée dans le machine learning, GrayMeta, pour enrichir la retransmission du mariage princier entre le Prince Harry et Meghan Markle.

Ces technologies ont été combinées pour identifier les invités du mariage lorsqu’ils entraient dans la chapelle. Via un système de tracking automatique, les noms des invités s’affichaient en direct sur l’écran des téléspectateurs durant le direct. Ce « Royal Wedding : Who’s Who en live » était accessible via l’application de Sky News ou le site SkyNews.com. Il était également possible d’accéder à une fiche de chaque invité identifié.

Si Hugh Westbrook, le chef de projet en charge de cette expérimentation, se félicitait de la « remarquable valeur ajoutée de ce service pour le téléspectateur », il reconnaissait aussi dans le même temps « l’importance de la curation humaine pour contrôler les informations distillée par les algorithmes ».

Sky Digital a toutefois mesuré que la technologie de reconnaissance atteignait en moyenne 70 % de pertinence durant le live et 80 % lors de la distribution en VOD, qui a permis de faire plusieurs passes. Sky envisage d’ores et déjà de renouveler l’expérience pour le sport, d’autres cérémonies et des événements politiques. La chaîne payante envisage même de faire payer les téléspectateurs à la durée pour accéder à ce service de TV enrichie.

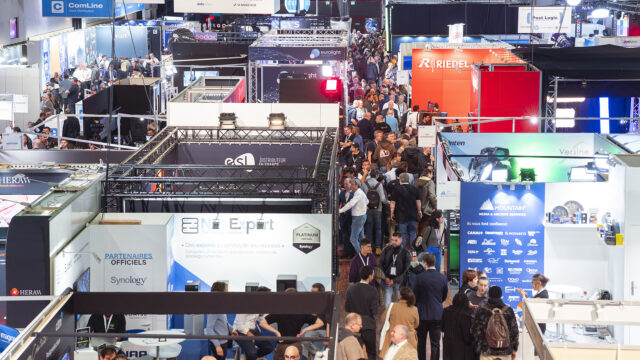

Extrait de notre compte-rendu de l’IBC 2018 paru pour la première fois dans Mediakwest #29, p.36/77. Abonnez-vous à Mediakwest (5 numéros/an + 1 Hors-Série « Guide du tournage ») pour accéder, dès leur sortie, à nos articles dans leur intégralité.